最近,IEEE Spcetrum发表了一篇报道,介绍了Meta在自监督学习领域,尤其是基于Transformsers的MAE系统的研究进展,现编译如下:

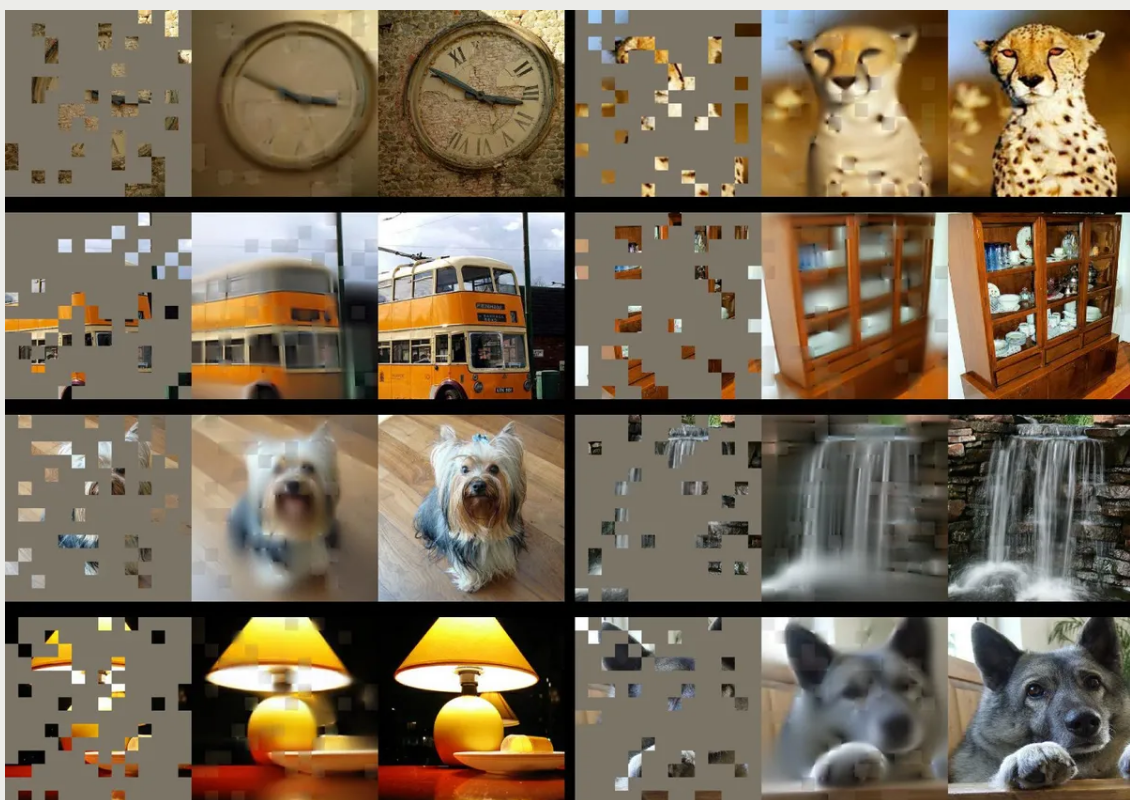

Meta AI 用于计算机视觉的掩码自编码器是在大部分被遮挡的图像上训练的 [左]。 然而,它的重建 [中心] 非常接近原始图像 [右]。

Meta首席AI科学家Yann LeCun即使谈论具体工作,也不忘联系其未来的理想。“我们希望构建出能像动物和人类一样进行学习的智能机器。”LeCun在接受IEEE Spectrum采访时表示。

具体的实施工作包含在Meta(前身为Facebook)的一系列论文中,内容涉及到一种用于AI系统的自监督学习(SSL)。SSL与监督学习形成鲜明对比:在监督学习中,人工智能系统从标记的数据集中进行学习(标签就像教师,为人工智能系统进行结果校验,提供正确答案)。LeCun坚信SSL是构建“世界模型”人工智能系统的必要先决条件。这种AI系统将具有类似人类的能力,如理性、常识以及将知识技能从一个环境转移到另一个环境的能力。Meta发表的一些新论文中,还展示了一个称为屏蔽自编码器(MAE)的自监督系统,如何学会从非常零散和不完整的数据中重建图像、视频甚至音频的过程。虽然MAE并不是一个新想法,但Meta已经将工作扩展到了全新的领域。

LeCun说,一旦弄清楚如何预测静态图像、或视频或音频序列中的缺失数据,MAE系统一定可以建一个世界模型。“如果它能够预测视频中将要发生的事情,它必须了解世界是三维的,一些物体是无生命的、不会自行移动,其他物体是有生命的、更难预测,一直到预测有生命的人的复杂行为”。他说,一旦人工智能系统有了一个准确的世界模型,便可基于它付诸实践了。

“图像是来自自然界的信号,并不是为了消除冗余而构建的。这就是我们创建JPG时可以很好地压缩信息的原因。——Ross Girshick, Meta

“智能的本质是学会预测。”LeCun说。虽然他并未声称Meta的MAE系统与通用人工智能非常接近,但视其为重要的一步。

但并非所有人都认为Meta研究员们正走在通往人类水平智能的正确道路上。Yoshua Bengio便是质疑者。除了因为对神经网络的研究,和LeCun、Geoffrey Hinton一起获得图灵奖之外,Yoshua Bengio有时会与LeCun就AI中的重要概念进行友好的争论。在给IEEE Spectrum的一封电子邮件中,Bengio阐明了他俩研究目标中的一些异同点。

“我真的不认为我们目前的方法(自监督与否)足以弥合与人类智力水平的差距。”Bengio认为,AI领域还需要“质的进展”,才能真正使最先进的技术更接近人类水准的人工智能。

虽然他同意LeCun的观点,即推理世界的能力是智力的关键要素,但Bengio团队并不专注于可以预测的模型,而是那些能够以自然语言形式呈现知识的模型。他指出,这样的模型“将使我们能够将这些知识结合起来,以解决新问题,进行反事实模拟,或检查可能的未来“。Bengio的团队开发了一种新的神经网络框架,该框架比LeCun所青睐的框架更具模块化的性质。LeCun团队注重端到端的学习(学习初始输入和最终输出结果之间所有步骤的模型)。

Transformers热潮

Meta的MAE工作建立在一种称为Transformers、正成为趋势的神经网络架构之上。Transformers首先应用在自然语言处理中,结果引起了谷歌BERT和OpenAI GPT-3等模型性能的大幅提升。Meta AI研究员Ross Girshick表示,Transformers在语言方面的成功,导致计算机视觉社区的研究者们趋之若鹜地在自己领域去复现那些结果。

Meta研究者们并不是第一个成功将Transformers应用于视觉任务的。Girshick说,是谷歌对视觉Transformers(ViT)的研究启发了Meta团队。“通过采用ViT架构,它消除了尝试某些想法的障碍。”他告诉Spectrum。

Girshick与人合著了Meta的第一篇MAE系统论文,该论文涉及静态图像。它的训练类似于BERT和其他语言转换器,这种语言模型有巨大的文本数据库,并且缺少或“被屏蔽”了一部分单词。模型尝试预测缺失的单词,然后取消屏蔽缺失的文本,以便模型可以检查其工作,调整其参数,然后使用新的文本块测试。Girshick解释说,为了对视觉做类似的事情,该团队将图像分解成补丁,掩盖了一些补丁,并要求MAE系统预测图像中缺失的部分。

该团队的突破之一是发现遮罩大部分图像可以产生最佳效果 —— 这是与语言Transformers的关键区别,在语言Transformers中,可能有15%的单词被遮盖。“语言是一个非常密集和高效的沟通系统,”Girshick说:“每个符号都有很多含义。但是,图像是来自自然界的信号,其构造并不是为了消除冗余。这就是为什么我们在创建JPG图像时可以很好地压缩信息。”

Meta AI研究人员尝试了要遮盖多少图像以获得最佳结果。

Girshick指出,通过遮盖图像中超过75%的补丁,他们消除了图像中的冗余,否则这些冗余会使任务变得过于琐碎而无法进行训练。他们的MAE系统分两部分,首先使用编码器来学习训练数据集中像素之间的关系,然后解码器尽最大努力从屏蔽版本中重建原始图像。完成此训练方案后,编码器还可以针对视觉任务(如分类和物体检测)进行微调。

“我们最终感到兴奋的原因,是我们将学习转移到了下游任务中,并看到了结果。”Girshick说。他说,当使用编码器执行对象识别等任务时:“我们的收获是非常实质性的,它们移动了速度盘的指针。”他指出,扩展模型可以带来更好的性能,这对于未来的模型来说是个好消息,因为SSL“有可能使用大量数据无需手动注释“。

全力以赴地学习大量未记录的数据集可能是Meta改善SSL结果的策略,但它也是一种越来越有争议的方法。如Timnit Gebru等AI伦理研究员已经呼吁人们注意:大语言模型从中学习的未记录数据集存在固有的偏见,有时会产生灾难性的结果。

视频和音频中的自监督学习

在面向视频的MAE系统中,每个视频帧遮蔽了高达95%的内容,因为帧之间的相似性意味着视频信号比静态图像具有更多的冗余。Meta研究员Christoph Feichtenhofer说,MAE方法在视频方面的一大优势是,视频通常对计算要求很高,但是通过屏蔽每帧95%,MAE也将计算成本降低了95%。

实验中使用的剪辑只有几秒钟长,但Feichtenhofer表示,在更长的视频上训练AI系统是“一个非常活跃的研究课题”。他说,想象一下:一个虚拟助手有你家的视频源,便可以告诉你一个小时前把钥匙放在哪里。(无论你认为这是惊人的,还是令人毛骨悚然的,请放心它的实现还很遥远)。

更直接地,人们可以想象图像和视频系统对于Facebook和Instagram上内容审核所需的分类任务很有用,Feichtenhofer说“完整性”是一种可能的应用。“我们肯定会与产品团队交谈,”他说:“但它非常新,我们还没有任何具体的项目。“

对于音频MAE的工作,该团队表示论文将很快发布在arXiv上,Meta AI团队已经找到了一种巧妙的方法来应用屏蔽技术。他们将声音文件转换为频谱图,即信号中频率频谱的视觉表示,然后屏蔽这些图像的一部分进行训练。重建的音频非常令人印象深刻,尽管该模型目前只能处理几秒钟的剪辑。

从事音频系统工作的Bernie Huang表示,潜在的应用包括分类任务,通过填充丢失音频(数据包丢失)来支持IP语音呼叫,或者找到更有效的方法来压缩音频文件。

Meta一直在进行一些人工智能魅力攻势,进行开源研究,例如这些MAE模型以及预训练大预言模型均提供给AI社区,用于研究目的。但批评人士指出,Meta并没有将其核心商业算法开源,即控制新闻源、推荐和广告投放的算法。

原文链接:https://spectrum.ieee.org/unsupervised-learning-meta