Evaluating Object Hallucination in Large Vision-Language Models

解决问题:该论文旨在研究大规模视觉语言模型(LVLM)中的对象幻觉问题,以及探讨视觉指令对幻觉的影响。该问题在当前领域中是一个新的问题。

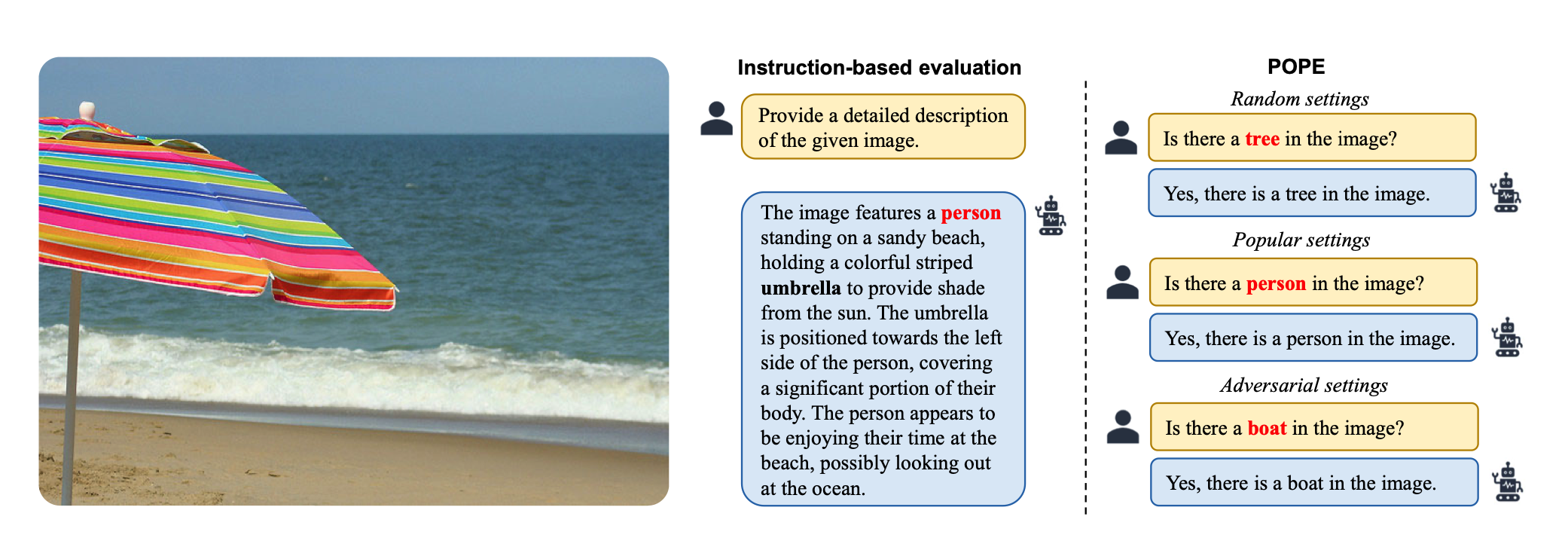

关键思路:该论文通过对几个代表性的LVLM进行评估实验,发现它们大多数存在严重的对象幻觉问题。同时,论文还指出,视觉指令可能会影响幻觉的产生。为了更稳定、更灵活地评估对象幻觉,论文提出了一种基于投票的查询方法POPE。相比当前领域的研究,该论文的主要新意在于针对LVLM中的对象幻觉问题提出了一种新的评估方法。

其他亮点:该论文的实验数据和代码公开可用,值得关注。此外,论文还指出现有的评估方法可能会受到输入指令和LVLM生成风格的影响。该问题值得进一步研究。

关于作者:本文的主要作者是Yifan Li、Yifan Du、Kun Zhou、Jinpeng Wang、Wayne Xin Zhao和Ji-Rong Wen

Yifan Li、Yifan Du、Kun Zhou、Jinpeng Wang、Wayne Xin Zhao和Ji-Rong Wen来自中国人民大学高瓴人工智能学院,Jinpeng Wang来自美团。

http://aibox.ruc.edu.cn/index.htm

论文摘要:本文题为《评估大型视觉语言模型中的物体幻觉》,作者为Yifan Li、Yifan Du、Kun Zhou、Jinpeng Wang、Wayne Xin Zhao和Ji-Rong Wen。受大型语言模型(LLM)优越的语言能力的启发,近期出现了大型视觉语言模型(LVLM),通过将强大的LLM集成到其中,以提高复杂多模态任务的性能。尽管LVLM取得了令人满意的进展,但我们发现它们存在幻觉问题,即它们往往会生成与描述中目标图像不一致的物体。为了调查这一问题,本文首次系统地研究了LVLM的物体幻觉问题。我们对几个代表性的LVLM进行了评估实验,并表明它们大多数都存在严重的物体幻觉问题。我们进一步讨论了视觉指令可能会影响幻觉,并发现:在视觉指令中频繁出现或与图像物体共同出现的物体,很明显容易被LVLM产生幻觉。此外,我们发现现有的评估方法可能会受到输入指令和LVLM的生成风格的影响。因此,我们进一步设计了一种改进的物体幻觉评估方法,提出了一种基于投票的查询方法,称为POPE。实验结果表明,我们的POPE可以更稳定、更灵活地评估物体幻觉。我们的代码和数据公开在https://github.com/RUCAIBox/POPE。

论文地址:https://arxiv.org/pdf/2305.10355.pdf

Github地址:https://github.com/RUCAIBox/POPE