年初 ChatGPT 爆火,美国《时代周刊》发文揭露其背后的「血汗工厂」,给「AIGC 领头羊」耀眼的光环蒙上了一层巨大阴影。

据报道,为训练 ChatGPT 识别有害内容,一群来自肯尼亚、乌干达和印度的外包员工负责给数据库手动标注,他们每天花费 9 小时鉴别各种攻击性词汇,每小时至多标注 2 万个单词,收获是 1.32-2 美元的时薪以及持久的心理创伤。

报道一出,舆论哗然,这堪称人工智能时代最不智能的操作。抛开劳工问题,此事件也折射出监督学习一大痛点:

为 AI 模型尤其是大模型准备大规模、预先标注的训练数据,是件相当耗力的事。

作者 | 铁塔

编辑 | 三羊

本文首发于 HyperAI 超神经微信公众平台~

在全息显微图重建(Holography microscopic reconstruction) 领域,这一问题也给科研工作带来了旷日持久的折磨。

深度学习在计算成像和显微成像方面的现有应用,主要依赖于监督学习,需要大规模、多样化和预先标注的训练数据,但此类训练图像数据集的获取和准备通常很费力且成本高昂,而且这些方法往往对新样本类型的泛化有限。

今年 8 月 7 日,加州大学洛杉矶分校的研究团队在 「Nature Machine Intelligence」 杂志报告了一个名为 GedankenNet 的自监督模型,其突出特质是无需真实数据或实验对象投喂,可直接从思想实验 (Thought experiment) 和物理规律中学习,且具备优异的外部泛化性 (External generalization)。

论文链接:

https://www.nature.com/articles/s42256-023-00704-7

GedankenNet 源于德语Gedankenexperiment,意为「思想实验」,明明白白告诉你:

我,GedankenNet,和外面那些从真实数据和实验对象中学习的 AI 模型不一样,我的学习对象,是爱因斯坦等科学家们都在用的思想实验!

该模型有望革除深度学习在全息显微图重建领域的弊病,为解决全息术、显微镜和计算成像中的逆问题创造出新机会。

全息显微图重建

先来简单了解一下 GedankenNet 的应用领域——全息显微图重建。

数字全息显微成像(Digital holographic microscopy) 是一种广泛用于生物医学和物理科学及工程的无标签成像技术,与传统的二维显微成像相比,全息显微图提供了一种更全面、非破坏性、高分辨率的显微观察和分析方法,它使用光学干涉技术从采集的全息图数据中恢复原始物体的三维形态,可帮助科学家和研究人员更好地理解和研究微观世界。

如何进行显微全息图重建呢?传统方法主要分为两类:

基于物理前向模型和迭代误差减少的迭代相位恢复算法;

基于有监督深度学习的推理方法。

第一类方法通过迭代优化来逐步改进对复数场 (Complex field) 的估计。首先利用物理模型计算出由复数场引起的理论全息图与实际测量的全息图之间的误差,随后根据这个误差进行调整,重复该过程直到实现一定的准确度。

第二类方法训练一个深度神经网络来学习从输入全息图到复数场的映射,通常由成对的全息图和对应的复数场作为训练数据,让神经网络学习这些数据对之间的关系,从而预测和重建复数场。

注:复数场,描述物体光学性质分布,包含光场的振幅和相位信息。

不过这些传统方法通常需要多次迭代来调整和优化预测的全息图,速度较慢,而 GedankenNet 采取了完全不一样的思路,既避免了迭代过程,又取得了更好的重建结果和更快的速度。

走近GedankenNet

模型训练

1.方法

与现有的基于学习的方法不同,GedankenNet 不直接比较输出复数场与真实复数场的差异,而是通过观察输入的全息图和相应的目标输出(比如清晰的图像),从带有物理一致性约束的数据中学习到复数场的重建模式,并生成相应的全息图预测,而无需逐步迭代调整。

物理一致性损失是 GedankenNet 训练方法的核心组成部分,它基于波动方程 (Wave equation) 的条件和实际观测数据之间的差异来度量重建结果的准确性。

通过最小化物理一致性损失,模型能够将观察数据与波动方程的预期行为相匹配,从而得到更符合物理规律的全息图重建结果。

2.数据集

GedankenNet 的训练数据集由随机图像产生的人工全息图组成,这些人工全息图从随机图像或自然图像(COCO 数据集)模拟,使用 Python 随机图像包生成随机图像(与真实世界样本没有连接或相似性)。

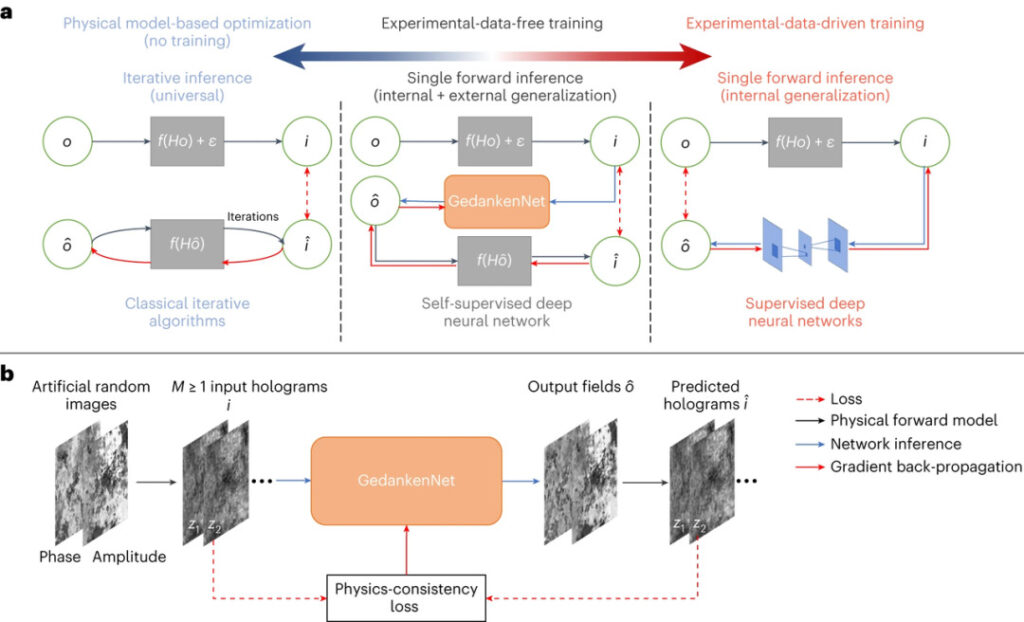

图1:GedankenNet 示意图和其他现有解决全息成像问题的方法

a. 经典迭代全息图重建算法、自监督深层神经网 (GedankenNet) 和现有的监督深层神经网络

b. GedankenNet 的自监督训练过程

模型验证

1.重建图像质量

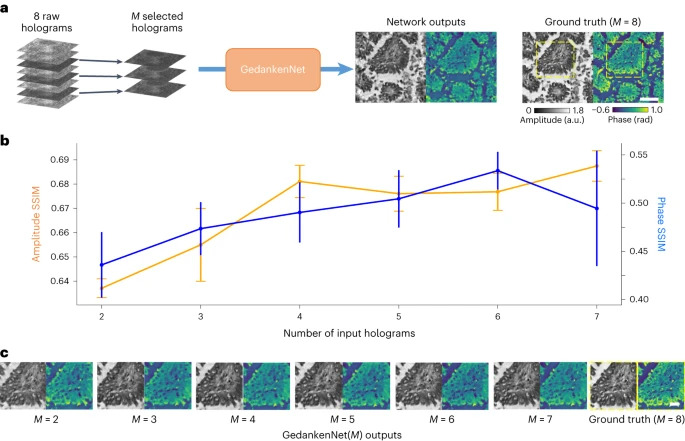

研究人员按照图 1 的训练过程,训练了一系列接受多个输入全息图(M 范围从 2 到 7 )的自监督网络模型,并采用MHPR(Multi-height phase retrieval) 多高度相位恢复算法从每个视场的 8 幅原始全息图中提取了真实对象图片,据此对比评估不同 GedankenNet 模型在重建图像质量方面的表现。

研究结果表明,即便没有使用实验数据进行训练,所有 GedankenNet 模型都以高保真度重建了样本场。

图2:GedankenNet 利用多 (M) 输入全息图进行全息重建的性能

2.外部泛化能力

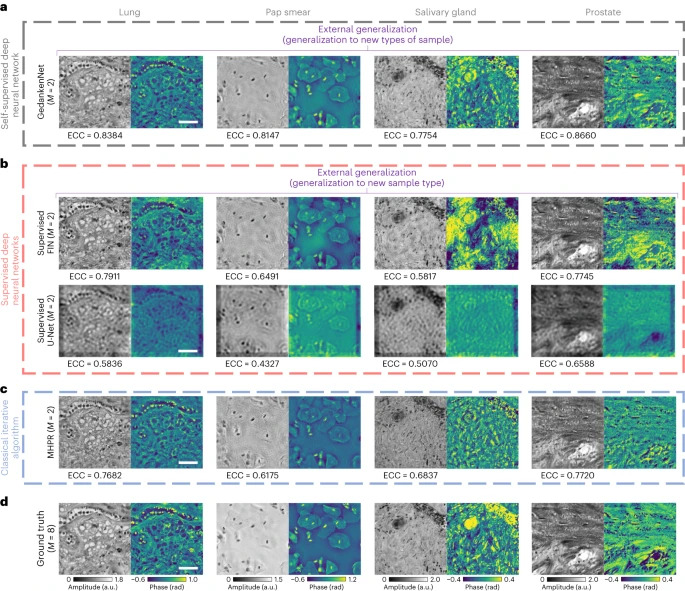

为验证 GedankenNet 的外部泛化能力,研究人员将 GedankenNet 模型与其他监督学习模型(基于相同的人工图像训练集训练而成)、迭代相位恢复算法进行了对比,测试数据采用包括人体组织切片和宫颈涂片在内的实验全息图。

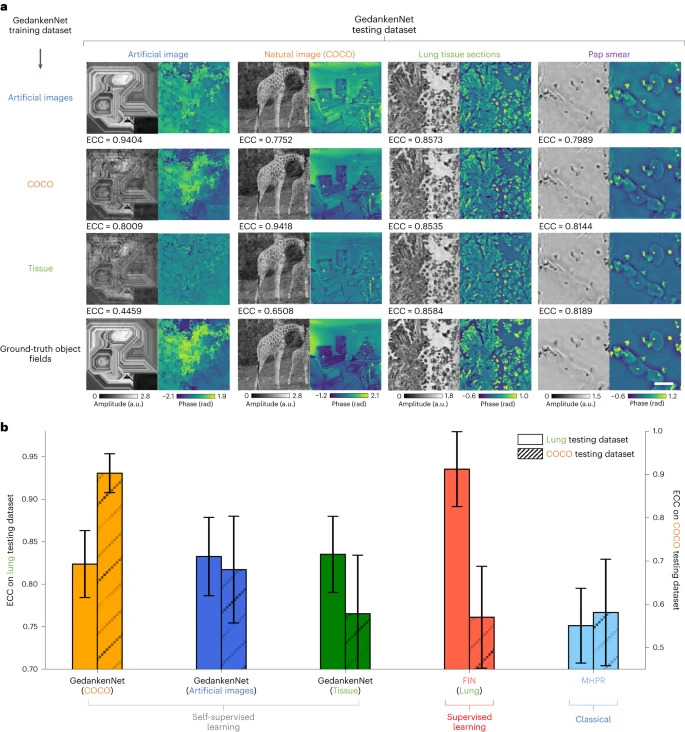

如下图所示,与这些监督学习方法相比,GedankenNet 在所有 4 种样本(肺、唾液腺和前列腺组织切片以及巴氏涂片 (Pap smear) )上表现出更好的外部泛化性,得到了更高的增强相关系数 (ECC) 值。

此外,研究人员还针对经典的迭代相位恢复算法,即 MHPR 进行了比较分析。结果显示,与使用相同输入全息图的 MHPR(M=2) 相比,GedankenNet 推断的复数场具有更少的噪声和更高的图像保真度。

图3:GedankenNet 对人体组织切片和巴氏涂片外部泛化结果,以及与现有监督学习模型和 MHPR 的比较

a. GedankenNet 在人体肺部、唾液腺、前列腺和巴氏涂片全息图上的外部泛化,以及与现有监督学习模型和 MHPR 的比较

b. 监督学习方法在同样的测试数据集上的外部泛化结果。这些监督学习模型使用与 GedankenNet 相同的模拟全息图数据集进行训练

c. 使用相同的 M = 2 输入全息图的 MHPR 重建结果

d. 使用每个视场 (FOV,fields-of-view) 的 8 个原始全息图获取的地面真实复数场的结果。标尺:50 m

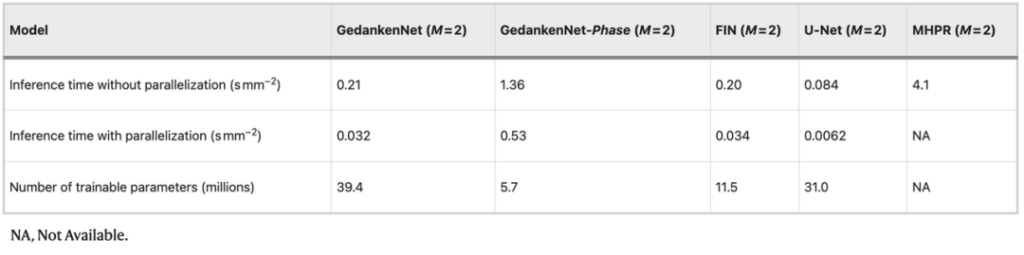

表1:GedankenNet、监督学习模型和 MHPR 的全息图像推理时间(样本面积:1 mm)

如表 1 所示 ,与 MHPR(M = 2)相比,GedankenNet 将图像重建过程加速了约 128 倍。

综上,这些全息成像实验和结果分析成功证明了 GedankenNet 对未知新型样本优越的泛化能力,并能实现出色的图像重建性能。

3.对其他训练数据的泛化

为证明其他数据集训练出来的 GedankenNet 也具备同样性能,研究人员使用以下数据集单独训练了 3 个 GedankenNet 模型:

(1)从随机图像生成的人工全息图数据集,与之前相同

(2)从自然图像数据集 (COCO) 生成的新的人工全息图数据集

(3)人肺组织切片的实验全息图数据集

这 3 个单独训练的 GedankenNet 模型在 4 个测试数据集上进行了测试,包括随机合成图像的人工全息图、自然图像的人工全息图,以及人肺组织切片、宫颈涂片的实验全息图。

图4:不同 GedankenNet 对其他测试数据集的泛化

研究结果显示,所有的自监督 GedankenNet 模型在内部和外部泛化方面都表现出优异的图像重建质量(图4a,b)。

值得注意的是,如图 4b 中的红条所示,监督模型在内部和外部泛化表现之间的性能差距较大,表明了其过拟合现象。相反,GedankenNet 模型(蓝条)展现出了非常好的泛化性能,覆盖了自然宏观图像和微观组织图像的测试数据集。

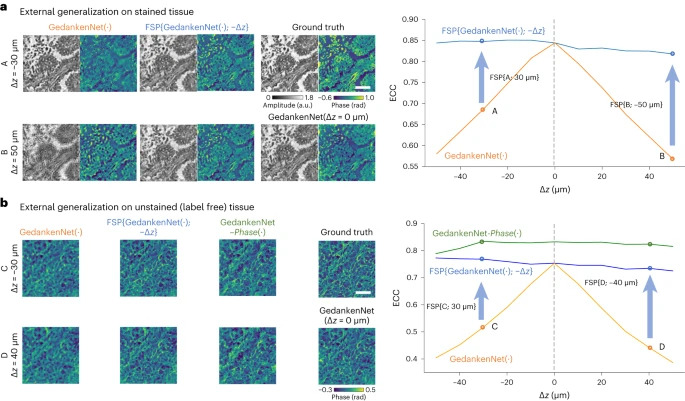

4.与波动方程的兼容性

与图 3 相同的模型被用于分析 GedankenNet 是否与波动方程相容,方法是在肺组织切片上进行盲目测试。

结果显示,在使用偏焦全息图进行测试时,GedankenNet 输出了正确的(物理一致的)偏焦复杂场,而不是产生幻觉和非物理随机光场。

从这个意义上说,GedankenNet 不仅展示了优越的外部泛化能力(从无实验和数据的训练到实验全息图),还很好地适应了偏焦实验全息图的工作。以往的文献中,尚未有任何全息图重建神经网络表现出这些特性。

图 5 :GedankenNet 输出图像与自由空间波动方程的兼容性

AI 具备「智慧」了吗?

作为自我监督的人工智能模型,GedankenNet 消除了对大规模、预先标注的训练数据需要,展示了优越的外部泛化能力和高质量全息图的重建结果。正如论文作者之一、加州大学洛杉矶分校电气与计算机工程、生物工程系教授Aydogan Ozcan所言:

「这些发现说明了自监督人工智能从思想实验中学习的潜力,就像科学家那样。它为开发物理兼容、易于训练和广泛通用的神经网络模型开辟了新机会,可替代目前在各种计算成像任务中采用的标准、有监督深度学习方法。」

一直以来,人们对 AI 是否具备真正意义上的智能争吵不休,毕竟即便强悍如击败多个世界围棋冠军、攻占人类智慧堡垒的 AlphaGo ,其本质也是无需理解规则、仰仗算力不断重复数学公式的代理罢了。

但如今这个能像科学家那样从思想实验中学习 GedankenNet 模型的问世 ,是否意味着 AI 已经在某种程度上具备人类独一份的「智慧」了呢?欢迎大家在留言区畅所欲言哦。

参考链接:

https://www.sciencedaily.com/releases/2023/08/230807122001.htm

本文首发于 HyperAI 超神经微信公众平台~