导读

将强化学习算法应用于现实场景的障碍之一是缺乏合适的奖励函数。这样的奖励函数很难人为设计,一定程度上是因为无法明确表述用户对任务目标的理解。这就产生了智能体对齐问题,即如何创造出行为符合用户意图的智能体?

时任DeepMind安全团队的作者Jan Leike在一篇博文中探讨这个问题并提出了一些见解。博文概述了团队的论文《Scalable agent alignment via reward modeling: a research direction》,其中指明了解决智能体对齐问题的一个研究方向。他们的方法是递归地实施奖励建模,从而能够以符合用户意图的方式解决复杂的现实世界问题。安远AI翻译了这篇博文,供中国读者学习和批评。

安远AI将联合机器之心在7月8日傍晚19:00-20:15在线上举办本文合著者剑桥大学机器学习和计算机视觉专业的助理教授David Krueger的讲座,进一步探讨”如何能让AI系统追求正确的目标?”。如果你对本文讨论的观点感兴趣,请查看我们即将举办的演讲活动,扫描下方二维码填写表单报名活动、参与赠书、加入活动交流群。

智能体对齐问题

最终,AI进步的目标是帮助人类解决现实世界中日益复杂的挑战,从而造福人类。但现实世界并没有内置的奖励函数,这对人类评价AI的性能提出了挑战。因此,需要找到一个理想的反馈机制,让AI能够充分理解人类的意图并帮助人类达成目标。换句话说,我们想用人类的反馈来训练AI系统,使系统的行为与我们的意图相一致。在本文中,DeepMind的研究人员将「智能体对齐」问题定义如下:

如何才能创造出行为符合用户意图的智能体?

对齐问题可以用强化学习的框架来表述,只是智能体不再接受数值化的奖励信号,而是通过互动协议与用户互动,让用户向智能体传达他们的意图。这个协议可以有多种形式:例如,用户可以提供演示(模仿学习,如谷歌的模仿学习机器人)、偏好倾向(人类直接评价结果,如 OpenAI和DeepMind的你做我评)、最优动作、传达奖励函数等。总的来说,智能体对齐问题的解决方案之一,就是学习一个行为符合用户意图的策略。

DeepMind《Scalable agent alignment via reward modeling: a research direction》的论文中指明了解决智能体对齐问题的一个研究方向。基于过去在AI安全问题分类和问题阐述方面所做的工作,我们将描述这些领域至今所取得的进展,以及这些进展如何为智能体对齐问题提供解决方案。这也能够启发研究者构建善于与用户互动,从用户反馈中学习,以及能预测用户偏好的系统。无论是在近期相对简单、受限制的领域,还是长期来看超越人类理解能力的复杂和抽象的领域,我们都希望系统能够胜任其中的任务。

通过奖励建模实现对齐

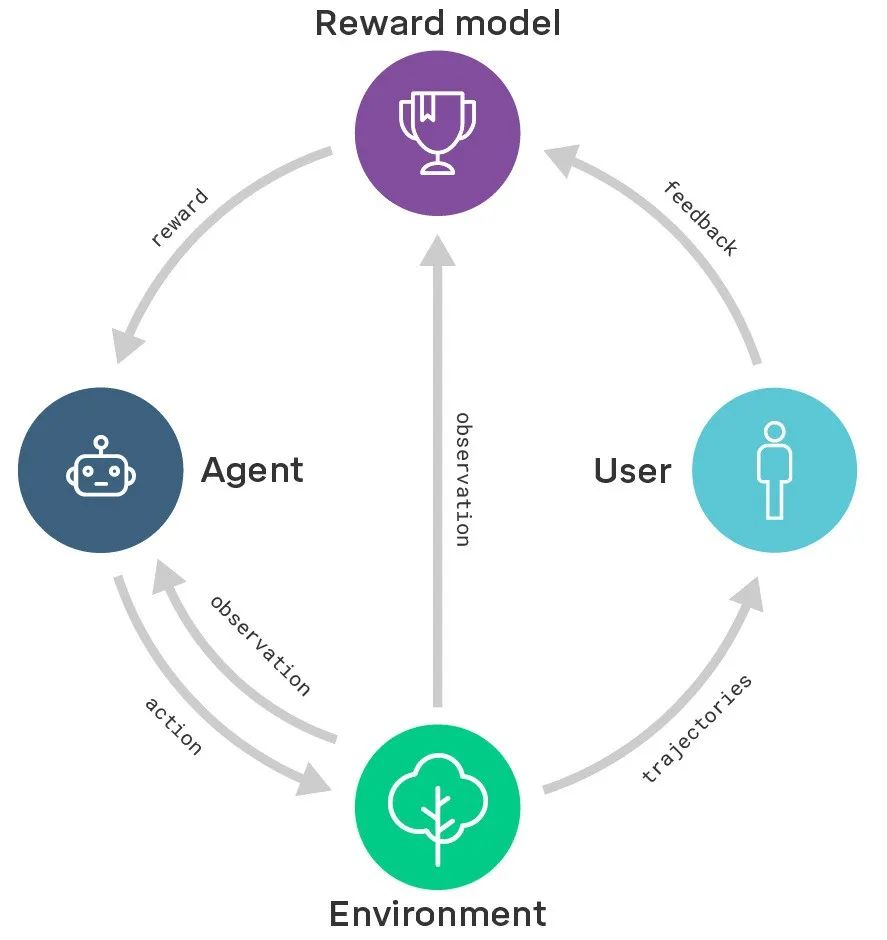

DeepMind这项研究方向的核心在于奖励建模。我们通过用户的反馈来训练一个奖励模型,以获取用户的意图。同时,我们用强化学习来训练一个策略,使奖励模型生成的奖励最大化。换句话说,我们把学习做什么(奖励模型)和学习怎么做(政策)区分了开来。

奖励建模示意图:奖励模型基于用户反馈进行训练,以便更好地获取用户意图;同一时间,奖励模型为经过强化学习训练的智能体提供奖励。

过去DeepMind做过一些类似的工作,比如教智能体根据用户喜好做后空翻,根据目标状态的示例将物体排列成特定形状,根据用户的偏好和专家的演示来玩雅达利游戏。将来我们希望设计出新的算法,这些算法会学习如何适应用户提供反馈的方式(例如,使用自然语言)。

向更复杂的领域扩展

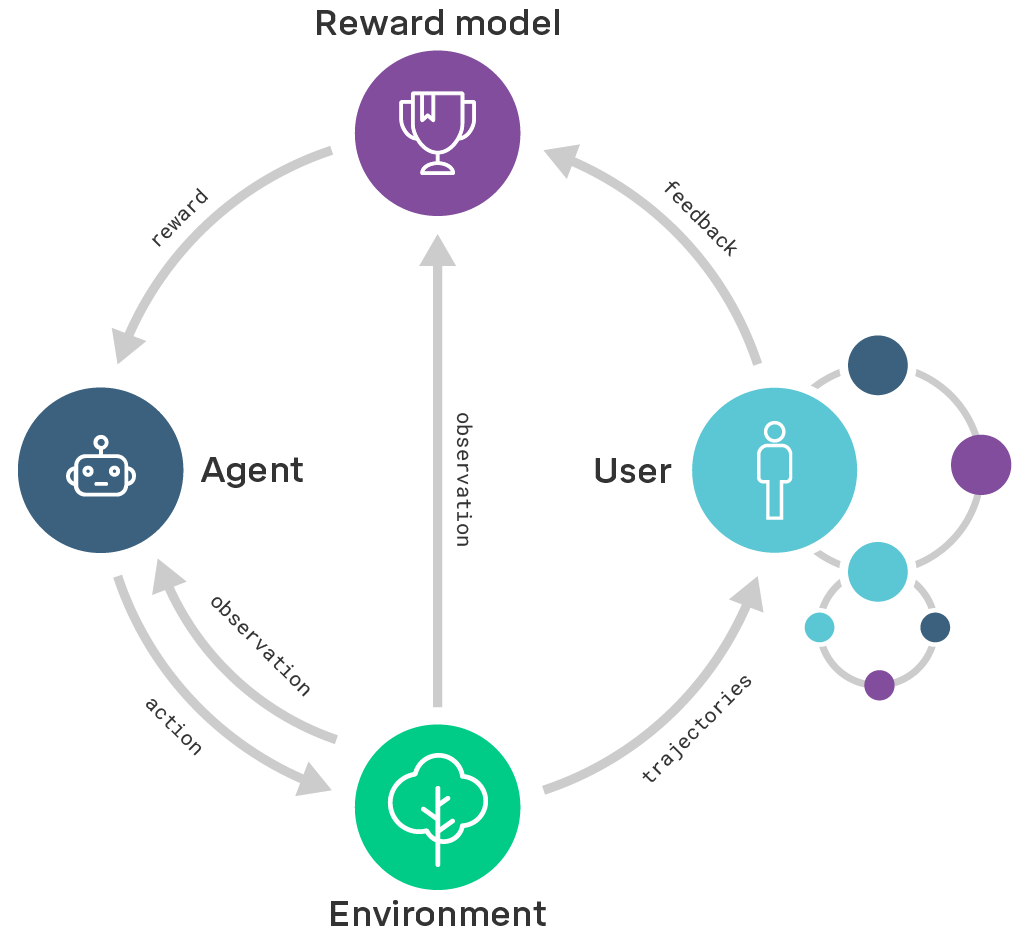

从长远来看,我们希望将奖励建模扩展到那些复杂到人类无法直接评估的领域。要做到这一点,我们需要提升用户评估结果的能力。因此,我们将探讨如何递归地应用奖励建模:通过奖励建模来训练在评估过程中协助用户的智能体。如果评估比行为更容易,就可以从简单的任务出发,完成越来越通用和复杂的任务。这个做法可以被理解为 迭代扩增(iterated amplification)的一个实例。

递归奖励建模的示意图:当前正被训练的智能体(左边大圆形)会产出结果,用递归奖励建模训练出的智能体(右边小圆形)在评估这些结果的过程中协助用户。

举例来说,设想我们要训练一个智能体来设计计算机芯片。为了评估所提出的芯片设计,我们用奖励模型训练其他的”辅助”智能体,在模拟环境中对芯片的性能进行基准测试,计算散热,估计芯片的寿命,试图找到安全漏洞,等等。这些辅助智能体的输出放在一起,会协助用户评估所提出的芯片设计,使用户可以训练芯片设计智能体。虽然每个辅助智能体都要解决非常困难的、对于今天的ML系统来说还是遥不可及的任务,但这些任务至少比设计芯片更容易:要设计一个计算机芯片,你必须了解每一个评估任务,反之则不然。在这个意义上,递归奖励建模可以使我们用智能体支持我们解决越来越难的任务,同时与用户的意图保持一致。

研究面临的挑战

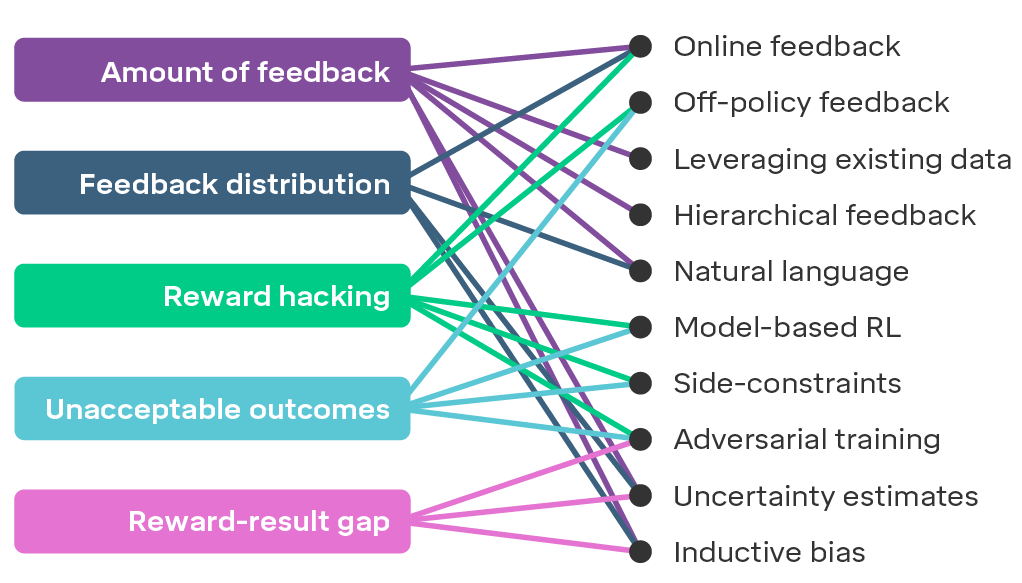

如果想将奖励建模应用到复杂的问题上,有几项挑战依然等待着我们去克服。下图展示了5项在研究中可能面临的挑战,对此感兴趣的同学可以查阅DeepMind论文,文中详细描述了这些挑战及对应的解决方案。

我们预期在扩展奖励建模时会遇到的挑战(左侧)和有希望应对这些挑战的方法(右侧)

我们预期在扩展奖励建模时会遇到的挑战(左侧)和有希望应对这些挑战的方法(右侧)未来的研究方向

虽然我们相信递归奖励建模是一个非常有前途的训练对齐智能体的方向,但我们目前不知道它的扩展性有多好(需要更多的研究!)。不过值得庆幸的是,智能体对齐还有几个其他的研究方向正在同时向前发展:

-

模仿学习 (Imitation learning)

-

短视强化学习(Myopic reinforcement learning)

-

逆强化学习(Inverse reinforcement learning)

-

合作式逆强化学习(Cooperative inverse reinforcement learning)

-

迭代扩增(Iterated amplification)

-

通过争论学习(Debate)

-

智能体基础组件设计(Agent foundations)

DeepMind在论文中进一步探讨了这些方向的异同。

主动开展计算机视觉系统对于对抗性输入的鲁棒性研究,对当今的ML应用至关重要。类似的,智能体对齐研究有望成为机器学习系统在复杂现实世界进行部署的关键。我们有理由感到乐观:虽然我们预计在扩展奖励建模时将面临挑战,但这些挑战是我们可以取得进展的具体的技术性研究问题。从这个意义上说,这研究方向今天已经准备就绪,可以进行深度强化学习智能体的实证研究了。

-

短视强化学习 阅读链接:http://www.cs.utexas.edu/~bradknox/TAMER.html -

迭代扩增 阅读链接: https://arxiv.org/abs/1810.08575 -

通过争论学习 阅读链接: https://arxiv.org/abs/1805.00899 -

合作式逆强化学习 阅读链接:https://arxiv.org/abs/1606.03137 -

智能体基础组件设计 阅读链接:https://intelligence.org/files/TechnicalAgenda.pdf

英文原文阅读链接为:https://deepmindsafetyresearch.medium.com/scalable-agent-alignment-via-reward-modeling-bf4ab06dfd84