Conformer LLMs — Convolution Augmented Large Language Models

P Verma

[Stanford University]

Conformer LLMs —— 卷积增强大型语言模型

-

动机:随着大型语言模型(LLM)在各种领域的应用,如对话系统、语音识别和图像处理等,如何进一步提升其性能成为了一个重要的研究问题。本文目标是将卷积层和Transformer结合起来,用于训练大型语言模型。

-

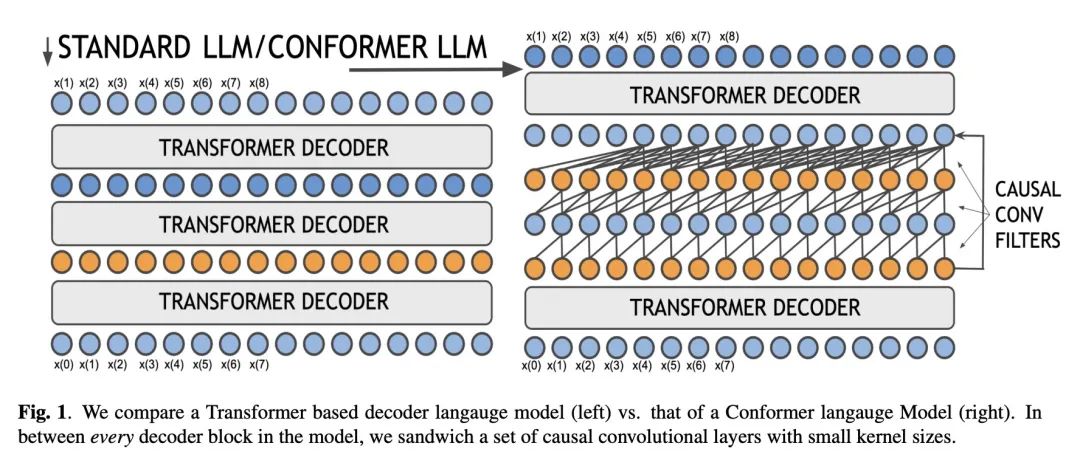

方法:提出一种名为Conformer的结构,它在每个Transformer解码器层之后添加了因果卷积滤波器。这种结构允许模型在学习过程中同时具有局部和全局的连接,同时可以根据任务的需要过滤或理解依赖关系。

-

优势:能有效地提升大型语言模型的性能。通过设计手工过滤器,可以在非因果设置中获得显著的性能提升。此外,该结构还能够很好地与解码器模块集成,并且随着嵌入大小、头数和卷积块的缩放而缩放。

提出一种名为Conformer的结构,将卷积层和Transformer结合起来,用于训练大型语言模型,从而有效地提升了模型的性能。

https://arxiv.org/abs/2307.00461

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...