点击下方卡片,关注「AI视界引擎」公众号

人类为中心的感知(例如行人检测、分割、姿态估计和属性分析)是计算机视觉的一个长期问题。本文介绍了一个统一和多功能的框架(HQNet)用于单阶段多人员多任务人类为中心感知(HCP)。

本文的方法侧重于学习一个统一的人类 Query 表示,称为人类 Query ,它捕捉了个人实例级的复杂特征,同时解耦了复杂的多人场景。尽管不同的HCP任务已经被单独研究,但尚未在文献中完全利用单阶段多任务HCP任务的学习,因为缺乏全面的基准数据集。

为了解决这个问题,本文提出了COCO-UniHuman数据集,以支持模型开发和全面评估。

1 Introduction

人类为中心的视觉感知(例如行人检测、姿态估计、人类分割和人类属性识别)由于其在广泛工业应用中的普及,如体育分析、虚拟现实和增强现实,越来越受到研究者的关注。

单阶段多人员多任务人类为中心感知(HCP)的任务在文献中尚未得到充分利用,原因在于缺乏一个代表性的基准数据集。因此,之前的研究所采用的方法是针对每个HCP任务在不同的数据集上训练模型,这带来了一定的局限性。

-

首先,不同数据集之间存在固有的规模差异。例如,人类检测数据集包括具有多个交互式人的场景图像,而属性识别数据集通常包含具有单个裁剪人的图像。这阻碍了开发可以全面解决各种HCP任务作为统一问题的单阶段多任务算法。

-

其次,单任务数据集通常针对特定的应用场景设计,导致不同数据集之间的数据集偏差。例如,某些数据集是在受控实验室环境中捕获的,而某些数据集是从监控视角捕获的。盲目地将这些数据集组合在一起训练模型无疑引入了数据集偏差,并阻碍了在实际、无约束场景中的性能。尽管为每个HCP任务提供了单独的基准,但仍然缺乏一个可以同时评估多个HCP任务的全面基准。

为了解决这个问题,作者引入了一个名为COCO-UniHuman的大规模基准数据集,专门设计用于统一人类为中心感知。

如图1所示,大多数流行的HCP任务可以分为四个基本类别:分类、检测、分割和关键点定位。COCO-UniHuman数据集通过为每个人员实例广泛标注性别和年龄标签,扩展了COCO数据集。它涵盖了这四个类别,包括6个不同的HCP任务(如图1中用对勾 Token )。

在多人员多任务人类为中心感知(HCP)的前期研究中,大多数方法采用了多阶段方法。这些方法通常涉及使用人类检测器检测人类实例,然后为每个单独的人感知任务(如姿态估计和实例分割)使用特定任务的模型。然而,这些方法存在三个显著的缺点。

-

首先,它们存在早期承诺问题:整个流水线的性能高度依赖于人体检测,如果人体检测器失效,则无法恢复。

-

其次,运行时间与图像中的人的数量成正比,使它们在实时应用中计算昂贵。相比之下,单阶段方法在一次遍历中估计所有所需的属性,从而提高了效率。

-

第三,这些方法忽视了潜在的任务协同作用。不同的HCP任务高度相关,因为它们共享对人体结构的共同理解。

在本工作中,作者开发了一个简单、直接和通用的 Baseline 框架,称为HQNet,用于单阶段多任务人类为中心感知。它将各种不同的人为中心任务统一起来,包括行人检测、人类分割、人类姿态估计和人类属性分析(特别是性别和年龄)。

不同的HCP任务具有各自相关但不同粒度的特征,以关注点为单位。例如,行人检测强调全局语义特征;属性识别需要全局和局部语义线索;人类分割依赖于细粒度的语义特征;而姿态估计需要细粒度的语义和定位信息。在本论文中,作者提出了一种学习统一的一站式 Query 表示的方法,称为人类 Query ,以编码多个视角的实例特定特征。

作者的工作受到基于DETR的方法的启发,这些方法使用可学习的 Query 嵌入来表示目标,并推理目标之间的关系和图像特征。本研究在这些工作的基础上,通过学习通用的实例级 Query 表示,以实现通用的人类为中心感知。尽管缺乏复杂的模型设计,但HQNet在各种基准测试中实现了最先进的结果。此外,作者还强调了HQNet的几个值得注意的特点,包括灵活性、可伸缩性和可迁移性。

灵活性: HQNet可以轻松地与各种 Backbone 网络(如ResNet,Swin和ViT)集成。

可伸缩性: HQNet中的权重共享 Backbone 、 Transformer 编码器和解器可以无缝集成多个任务,每个任务特定的 Head 的开销最小,从而证明了惊人的可伸缩性。

可迁移性: 实验表明,学习的人类 Query 对新的人类为中心感知任务(如面部检测和多目标跟踪)具有很强的可迁移性。值得注意的是,本工作不声称算法优越性,而是建立了一个具有优越性能的人类为中心感知的坚实 Baseline 。

作者的工作做出了以下关键贡献:

-

提出了COCO-UniHuman基准数据集,这是一个大规模的数据集,全面覆盖了所有代表性的HCP任务,即分类(性别和年龄估计)、检测(身体和面部检测)、分割和关键点定位。

-

开发了一个简单而有效的 Baseline HQNet,采用单阶段多任务方式将多个独特的HCP任务统一起来。关键思想是学习统一的一站式 Query 表示,称为人类 Query ,它从多个角度编码实例特定特征,以多种粒度进行。作者的方法在不同的HCP任务上实现了最先进的结果,证明了学习的人类 Query 的强大表示能力。

-

此外,实验表明学习的人类 Query 对新的人类为中心感知任务(如面部检测和多目标跟踪)具有很强的可迁移性。作者希望作者的工作可以为开发单阶段多人员多任务HCP算法提供启示。

2 Related Works

Human-centric perception tasks and datasets

人类为中心的感知(HCP)任务,包括姿态估计,分割,和属性识别,在计算机视觉领域得到了广泛的关注。多人员HCP的方法可以分为自上而下、自下而上和单阶段方法。自上而下的方法遵循检测然后分析的方法。它们首先定位人类实例,然后执行单人分析。

自上而下方法可以分为两种类型:使用单独预训练检测器和任务特定感知模型,和使用联合学习检测和感知模块。自下而上的方法学习实例无关的关键点/掩码,并使用整数线性规划,启发式贪心解析,嵌入聚类,或可学习聚类进行聚类。单阶段方法直接预测每个个体的关键点或掩码,具有不同的表示形式(基于坐标的,热力图的,或混合的姿势估计,以及基于轮廓的或掩码的分割。虽然大多数现有的方法都专注于单个HCP任务,旨在通过学习一个同时处理多个任务的一个模型来实现人类为中心的感知,从而实现对人类的全面理解。

如图1所示,针对不同的HCP任务,有许多单独标注的任务特定数据集,包括行人检测,姿态估计,人类分割,和人类属性识别。同时针对多个HCP任务的数据集也存在。广泛使用的COCO提供了详细的标注,包括身体框,关键点和分割掩码。作者的COCO-UniHuman数据集进一步扩展了COCO,具有广泛的性别和年龄标注。

Unified methods for HCP

不同HCP任务的通用网络架构。一些工作设计了通用的网络 Backbone ,包括基于CNN和基于Transformer的 Backbone 。其他人则通过新颖的感知头将HCP任务统一,如UniHead。与这些方法不同,作者将在单个网络中整合不同的HCP任务。HCP任务的预训练。 有一些工作对大规模的多样化人类为中心任务进行预训练。UniHCP提出了一种统一的视觉 Transformer 模型,在规模上进行多任务预训练。它使用任务特定的 Query 进行相关特征的注意,但一次只解决一个任务。与作者的方法不同,作者的方法在一次正向传播中同时解决多个HCP任务。

作者的方法与这些基于预训练的方法不同,避免了预训练,最小化了微调,并绕过了资源密集型多数据集训练。与它们不同,作者在单阶段、多任务方式下同时处理多个HCP任务,与他们的单人关注不同。HCP任务的联合学习。 许多工作研究了不同HCP任务之间的相关性[50, 61, 62, 75, 97]。作者提出了一种单阶段模型,该模型学习一个通用的统一表示,同时处理所有代表性的HCP任务。

Object-centric representation learning

DETR 开创了可学习的目标 Query ,以表示目标并与图像特征进行交互。Deformable DETR 引入了可变形注意力模块,以关注关键采样点,从而增强了收敛速度。DAB-DETR 将每个位置性 Query 都视为一个动态的4D Anchor 框,并在解码层中进行更新。DN-DETR 采用去噪训练以实现更快的收敛。最近,DINO 合并了这些技术,引入了一种混合 Query 选择和向前看两次策略,以加速并稳定训练。本文的工作受到基于DETR的方法的启发。尤其是,作者基于DINO并将其扩展到开发一个通用的框架,用于单阶段多任务人类为中心感知,统一多个独特的以人类为中心的任务。

3 COCO-UniHuman Dataset

COCO-UniHuman 是最大规模的数据集,为多人在场景下提供了四种代表性的 HCP 任务标注。在基于 COCO 的基础上,作者通过包含每个个体的性别和年龄信息丰富了标注。

唯一性。新引入的数据集与现有的 HCP 数据集相比具有几个显著的特点。

(1) 全面性: 这是第一个涵盖所有四种基本 HCP 任务(即分类、检测、分割和关键点定位)的多人场景下的大规模多人员 HCP 数据集。它有助于开发和评估单阶段多人员多任务 HCP 算法。

(2) 大规模和高多样性: 该数据集拥有超过 20 万张图像和 273,000 个身份,在照明条件、图像分辨率、人体姿势和室内/室外环境等方面表现出显著的变化。

(3) 多人员属性识别: 与其他现有仅提供单人中心裁剪图像的属性识别数据集不同,作者的建议数据集为多人员属性识别提供了有价值的基准,适用于具有挑战性的场景。

(4) 基于身体的显性年龄估计: 尽管以前的研究主要关注基于面部图像预测一个人的年龄,但作者的数据集强调利用从全身图像中获得的更丰富的视觉线索。将身体基于的视觉线索(如皮肤弹性、身体姿势和身体高度)纳入估计一个人的年龄是有益的,尤其是在面部图像不清晰的情况下(例如从远处拍摄)。值得注意的是,现有的大规模行人属性数据集通常只提供粗略的年龄组标注,而面部属性数据集[2]通常提供细粒度的显性或真实年龄标注。作者的建议数据集填补了这一差距,成为野外基于身体的显性年龄估计的领先大规模数据集。

(5) 增强的人类表示: 扩展的属性标签提供了关于个人除现有标签之外的其他描述性信息。通过利用这些属性标签,模型可以学习改进的人类表示,从而提高其他 HCP 任务的表现。此外,包括性别和年龄标签可以在下游应用中发挥价值(例如性别/年龄特定的 SMPL 模型选择)。

Data Annotation

为了确保准确的标注,作者使用经过训练的标注员手动标注数据集中每个人体实例的性别和显性年龄。作者排除所有包含非人类目标的图像,并排除所有难以识别属性的_小_类别人员。

性别标注。 对于每个有效的人体实例,作者采用基于身体的标注方法。使用提供的人体边界框,作者裁剪身体图像,并请标注员标注性别。为了保持数据质量,作者整个标注过程中进行质量检查和手动更正。

年龄标注。 为了提高标注质量,作者采用基于身体的两阶段策略。与性别标注类似,年龄标注也针对裁剪的身体图像进行。作者实现了一个从粗粒度到细粒度的两阶段标注策略,认为年龄组标注相对容易,而显性年龄标注[2]则较为困难。

在第一阶段,年龄组被标注。参考[44],作者将年龄范围分为六个组,即”婴儿”、”孩子”、”青少年”、”年轻人”、”中年人”和”老年人”。对于每个裁剪的人体图像,请一组10个标注员独立并重复地标注年龄组(6-类别分类任务)。将10个标注员投票的模式作为 GT 年龄组。

在第二阶段,显性年龄被标注。给定年龄组作为先验,一组10个标注员独立并重复地标注显性年龄。因此,为每个人体实例获得10个投票。作者删除异常值并取平均值作为最终 GT 显性年龄。

总之,该数据集包含超过100万个显性年龄投票。实验验证了基于身体的标注策略和两阶段标注策略的有效性(见第A2节)。

4 Method

Overview

本研究旨在开发一个单阶段框架,有效支持各种人类为中心感知(HCP)任务。关键是学习一个全面的人类表示,可以在各种HCP任务中普遍应用。为实现这一目标,作者采用基于 Query 的方法,并研究将每个人实例表示为单个共享 Query 的可行性。

作者的框架具有简单性、灵活性和可扩展性的特点。与先前的特定任务HCP模型(例如Mask DINO中的”mask-增强 Anchor 框初始化”)不同,作者的方法旨在以统一的方式处理各种人类为中心分析任务。为了最大限度地共享各种HCP任务之间的知识,作者试图在不同的HCP任务之间共享大部分权重。

如图2所示,作者的框架包括四个关键组件:Backbone 网络、Transformer编码器、任务共享Transformer解码器和任务特定头。Backbone 网络,如ResNet,将图像作为输入并产生多 Scale 特征。这些特征,以及相应的位置嵌入,然后通过Transformer编码器进行增强以获得特征表示。作者使用混合 Query 选择技术将初始 Anchor 框作为位置 Query 用于Transformer解码器。

遵循DINO,只初始化位置 Query 但不过初始化内容 Query 。与先前的使用特定任务的Transformer解码器的方法不同,提出使用任务共享解码器进行所有HCP任务。Transformer解码器包括变形注意力来在解码层中细化 Query 。将细化后的内容 Query 称为”人类 Query “,因为它们编码与人类实例相关的多样化信息。最后,人类 Query 被输入到每个轻量级任务特定头进行最终预测。

Task-shared Transformer Decoder

DETR类似模型中的 Query 由两部分组成:位置 Query 和内容 Query 。每个位置 Query 都表示为一个4D Anchor 框,编码框的中心x-y坐标、宽度和高度。作者的内容 Query ,称为”人类 Query “,包含每个实例特有的各种特征(局部和全局外观特征,以及粗粒度和细粒度的定位特征)。

对比性去噪 (CDN)。 为了提高训练稳定性和加速,采用了DINO中介绍的对比性去噪 (CDN)。值得注意的是,作者观察到为其他任务(例如分割和姿态估计)引入辅助去噪损失并不能带来显著的改进。因此,作者只针对人类检测应用DN损失。

人类 Query -实例匹配。 为了确保所有HCP任务(包括分类、检测、关键点和分割)中每个真实实例的预测一致且唯一,采用了人类 Query -实例(HQ-Ins)匹配。其中是相应的损失权重(参见第A4节详细说明)。

Task-specific Heads

为了保证可扩展性,将HCP任务分为三个类别,并为每个类别设计特定的实现范式。

坐标预测任务(例如目标检测和姿态估计)与边界框预测共享参考点,并直接回归每个点的归一化偏移量。

密集预测任务(例如实例分割和人类解析)遵循Mask DINO的设计,涉及将 Backbone 网络和Transformer编码器中的特征整合到一个高分辨率像素嵌入图中。

通过在内容 Query 嵌入和像素嵌入图之间执行点积操作,可以生成一个实例感知的像素嵌入图,从而促进像素级分类。

分类任务(例如确定一个实例是否是人类、性别和年龄估计)直接将人类 Query 映射到分类预测结果,因为人类 Query 本质上编码了位置信息。

为了最小化纳入新任务的开销,作者使用轻量级任务特定头,包括简单的线性层。以下是作者的四个任务特定头的详细信息:

人类检测Head。 使用3层多层感知机(MLP)预测输入图像相对于检测Head的归一化中心x-y坐标、高度和宽度。此外,还使用线性投影层(FC)预测类别标签(人类或非人类)。

姿态估计Head。 遵循坐标预测范式,将学习的人类 Query 输入到姿态回归头(MLP)中,以回归相对于检测Head的共享参考点的相对姿态偏移量。使用信心预测头(FC)预测可见关键点的信心分数。

遵循PETR,使用联合解码层利用身体关键点之间的结构关系来细化身体姿态。还使用辅助热力图分支来帮助训练并在测试时丢弃。

人类实例分割Head。 使用3层MLP处理实例感知的像素嵌入图并输出一个一通道掩码,然后将其上采样以匹配原始输入图像大小。

人类属性Head。 性别估计头和年龄估计头并行工作。两者都包括两个层MLP。性别估计涉及二分类,而年龄估计采用85类分类并使用softmax期望值估计。

5 Experiments

Dataset and Evaluation Metric

COCO-UniHuman数据集。 作者的模型训练仅使用COCO-UniHuman训练数据(除ImageNet预训练外),并遵循DINO进行增强,并采用100个epoch的训练计划。模型评估在COCO-UniHuman验证集(5K图像)上进行。由于COCO测试开发服务器缺乏支持”Person”类别评估和属性识别,作者在主要报告验证集上的结果。评估基于COCO标准指标,包括平均精确度(AP),AP_M(中等大小人员)和AP_L(大型人员)。由于COCO缺乏_Small_类别人员的标注,作者在评估过程中排除_Small_类别人员。对于属性识别,还使用带有Age-10指标的AP进行评估,其中如果预测误差不超过10,则认为年龄估计正确。

OCHuman数据集。 OCHuman数据集是一个专注于严重遮挡的人的大规模基准数据集。它不包含训练样本,仅用于评估目的。遵循[100],在COCO训练集中训练模型,并在OCHuman验证集(4731张图像)和测试集(8110张图像)上评估模型。

Results on COCO dataset

作者将作者的方法与任务特定和多任务HCP模型在COCO-UniHuman数据集上进行了比较,结果如表2所示。它超过了多任务HCP模型,并在与任务特定HCP模型相比取得了非常具有竞争力的结果。有关 Baseline 的更多详细信息可以在第A5节中找到。

与特定任务HCP模型的比较。 对于人类检测,作者将与两个基准方法进行比较,即Faster-RCNN和DINO。对于人类实例分割,作者将HQNet与最先进的通用和人类特定实例分割方法进行对比,包括Mask R-CNN,PolarMask,MEInst,YOLACT和CondInst。对于人类姿态估计,作者将与几种代表性的自上而下方法(SBL,HRNet,Swin和PRTR)进行比较,与自下而上方法(HrHRNet,DEKR和SWAHR)以及单阶段方法(FCPose,InsPose,PETR和CID)进行比较。

对于性别和年龄估计,作者使用StrongBL和Mask R-CNN建立 Baseline 。当使用R-50 Backbone 网络时,作者的方法与其他特定任务HCP模型相比具有非常具有竞争力的性能。此外,使用更强大的 Backbone 网络,如Swin-L和ViT-L,作者建立了新的最先进结果。

与多任务HCP方法的比较。 Pose2Seg是一种两阶段的基于人类姿态的实例分割方法。它使用一个独立的关键点检测器进行姿态估计,并使用人类骨骼特征进行自上而下的实例分割指导。

MultiPoseNet和PersonLab遵循自下而上的策略。CenterNet,LSNet和UniHead是单阶段替代方案。R-50模型在多任务HCP中实现了卓越的检测、关键点估计和分割性能,而无需额外的功能。

Results on the OCHuman dataset

为了验证HQNet在更具挑战性的密集场景中的性能,作者将它与最近在OCHuman基准测试上进行比较,该基准测试是针对人类检测、分割和姿态估计的拥挤场景热门基准。作者发现在相同的ResNet50 Backbone 网络下,作者的模型明显优于以前的方法。

例如,在测试集上,它比SBL提高了9.6个关键点AP,比CondInst提高了11.0个分割AP。它甚至超过了HrHRNet(40.3 vs 40.0)和LOGO-CAP(40.3 vs 39.0)的优越性能,即使使用的是更小的 Backbone 网络(ResNet-50 vs. HRNet-w32)。在更强大的 Backbone 网络,例如ViT-L下,作者的HQNet在检测(35.8 AP)、分割(38.8 AP)和姿态估计(45.6 AP)上创造了新的最先进结果。

Generalize to new HCP tasks

微调评估。 类似于图像分类中的线性检测,作者将 Backbone 网络和 Transformer 编码器(如表2所示)冻结,并仅对其他部分进行微调,以评估HQNet在新HCP任务(例如人脸检测)上的泛化能力。

在表4中,作者将作者的方法与Faster R-CNN和ZoomNet进行了比较。作者的HQNet不仅可以更好地利用人体固有的多级结构,而且还可以保持单阶段检测的高效性。它比Faster R-CNN(68.4 AP vs 43.9 AP)和ZoomNet(68.4 AP vs 58.2 AP)大幅优于。

未见任务(零样本)泛化。 作者通过一个未见任务评估来评估作者的方法的一般化能力,具体是多目标跟踪(MOT)在PoseTrack21数据集上。作者的模型仅在COCO-UniHuman图像数据集上进行训练,而没有针对MOT进行显式调整。

假设作者学习的人类 Query 嵌入,可以作为区分不同目标的强烈线索。使用DeepSORT,并将学习得到的人类 Query 作为关联的重新识别特征。

在表5中将结果与在COCO上预训练并在PoseTrack21上进行微调的两种最先进的单网络MOT方法进行了比较。尽管作者的HQNet(R-50)没有针对MOT进行显式训练,但它仍然取得了非常具有竞争力的结果(IDF1 64.6和MOTA 51.1)。这表明学习的Human Query具有很好的泛化能力。HQNet-Det指的是仅针对检测任务训练的HQNet,作者观察到在多个HCP任务上进行共同训练提高了 Query 嵌入的质量(IDF1 64.6 vs 62.4 IDF1)。

此外,通过使用更强的ViT Backbone 网络,作者的方法在零样本MOT评估中达到了最先进的结果。

Robustness to domain shift

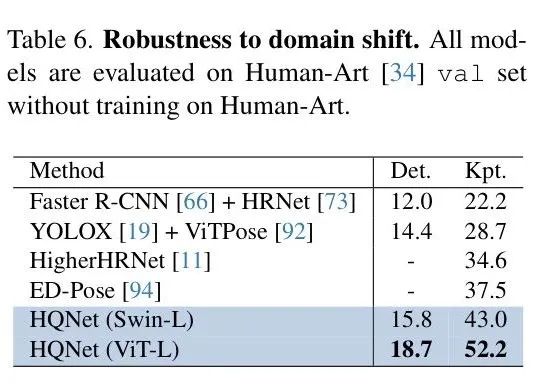

HumanArt数据集。 HumanArt数据集包含来自自然和人工(例如卡通和绘画)场景的图像,可用于评估对域转移的鲁棒性。在表6中,通过直接在Human-Art验证集上评估所有模型(不进行任何微调)来进行系统级别的跨域评估。观察到所有模型(尤其是两阶段模型)在存在域间隙时,性能都出现了下降。然而,作者的方法保持了具有竞争力的性能,展示了其对域间隙的弹性。

More Analysis

多任务共同学习。 在表7中,作者观察到与多个人类为中心任务共同学习可以提高整体性能。这种增强可以归因于不同任务之间的协同作用,即在共同训练不同的人类为中心任务时产生的跨任务协同作用。

计算成本分析。 在表7中,作者遵循[72]的方法来分析计算成本。具体来说,作者使用具有输入尺寸800×800的ResNet-50 Backbone 网络。

在HQNet中,多个任务共享 Backbone 网络、 Transformer 编码器和解码器的计算成本。每个任务特定头的开销可以忽略不计,表明HQNet在增加任务数量方面具有很好的可扩展性。

HQ-Ins匹配的影响。 如图3(左)所示,仅进行Box匹配可能会出现一个人体的姿态被匹配到另一个人的错误情况。HQ-Ins匹配通过全面考虑多个任务作为一个整体来避免这种错误。有关定量评估的更多信息可以在第A3.2节中找到。

6 Conclusion

在这项工作中提出了一种针对单阶段多任务人类为中心感知的统一解决方案,称为HQNet。核心思想是学习一个统一的 Query 表示(Human Query),它为每个实例编码不同的特征(局部和全局外观特征,粗粒度和细粒度的定位特征)。

为了方便模型训练和评估,作者引入了一个大规模的基准数据集,称为COCO-UniHuman,以统一不同代表性的HCP任务(包括分类、检测、分割和关键点定位)。作者广泛地将作者提出的方法与几种最先进的任务特定和多任务方法进行比较,并展示了作者提出的方法的有效性。

局限性。 尽管作者关注2D任务,但关于3D或顺序数据的任务也具有重要的潜力。作者鼓励未来的研究来探索更全面的跨任务人类为中心感知。

在图A1中,作者展示了作者提出的COCO-UniHuman数据集的统计数据。这些图表显示了性别和显性年龄的分布。作者发现在广泛使用的COCO数据集中存在性别和年龄偏见。在COCO数据集中,男性比女性出现的次数显著更高。更具体地说,男女性别比约为65:35。

此外,该数据集的年龄分布不平衡。显性年龄分布范围从[1, 84],主要集中在25到35岁之间。分析并解决计算机视觉系统中的性别和年龄偏见也是一个重要的AI社区话题。未来的工作也可以使用作者的基准数据集来全面测量和分析这些偏见,但这超出了本文的范围。

A2 COCO-UniHuman Dataset Annotation

获取可靠的显性年龄对于人类感知来说都是具有挑战性的。显性年龄不仅受到实际年龄的影响,还受到其他生物和社会因素(如”老化”)的影响。因此,同一年龄段的人在 appearance 上存在显著的差异。

在本工作中,作者提出了一种基于身体的两阶段标注策略,以提高年龄标注的质量。作者还进行了一些实验来展示所提出的年龄标注策略的有效性。

Body-based vs face-based annotation strategies.

在这项研究中,作者设计了一些实验来比较三种不同的标注策略。

首先,采用了基于人脸的标注策略,但在标注前不进行人脸对齐,标注仅基于裁剪的人脸图像;

其次,采用了基于人脸的标注策略,但在标注前应用了人脸裁剪和人脸对齐预处理,这样可以更好地捕捉人脸特征;

最后,采用了基于身体的标注策略,即标注基于裁剪的身体图像。作者随机选择了500个样本人物图像,并分别应用了上述三种策略处理数据,得到了三个数据集。

作者还随机将30个经过良好训练的标注员分为每组10个标注员的三组。每个数据集由一组标注员进行标注。每个标注员被要求对整个数据集的整个人或人脸图像独立给出显性年龄的投票。因此,对于每个人体或人脸图像,作者都有10个投票。作者将这10个投票的平均值作为真实年龄标注,并分别计算了Age-5和Age-10的准确性。Age-n一致性定义为:

其中,是图像的总数,是每个图像的投票数。是第张图像的第个投票,而表示第张图像的真实年龄标注。

从表A1中可以发现,基于身体的年龄标注优于基于人脸的年龄标注,表明全身图像包含更丰富的视觉线索用于年龄估计。有趣的是,作者发现人脸对齐可以帮助提高人类标注员的年龄估计一致性。

Two-stage vs one-stage annotation strategies.

在这项研究中,设计了一些实验来比较两阶段和一阶段的标注策略。对于一阶段的标注,直接对主体的显性年龄进行标注。对于两阶段的标注,首先对年龄组进行标注,然后根据年龄组进行显性年龄的标签。表A2显示,两阶段的标注策略可以提高标注的一致性。

A3 More Experimental Analysis

在这项研究中设计了一些实验来比较两阶段的标注策略。对于一阶段的标注,直接对主体的显性年龄进行标注。对于两阶段的标注,首先对年龄组进行标注,然后根据年龄组进行显性年龄的标签。表A2显示,两阶段的标注策略可以提高标注的一致性。

多任务共同学习可以缓解过拟合问题。 从图A2中,可以观察到,仅在”Person”类别上训练任务特定的模型很容易导致过拟合问题,随着训练轮次的增加,性能会降低。

具体来说,在这个实验中,比较了基于RCNN的方法(例如Faster-RCNN,Mask RCNN)的1x,2x和4x训练设置,以及基于DETR的方法(例如DINO,Mask DINO和作者的HQNet)的50-epoch和100-epoch设置。

这些模型使用MMDetection进行训练,并采用建议的超参数。在COCO-UniHuman验证集上报告了人类检测(实线)和人类实例分割(虚线)的平均精确度。有趣的是作者发现提出的多任务共同学习(HQNet)可以缓解过拟合问题,随着训练轮次的增加,性能始终会提高,这表明了良好的可扩展性。

General models vs person-specific models

在表A3中,作者将通用80类模型和特定人模型在COCO-UniHuman验证集上进行了比较。发现特定人模型在人类分析方面略优于通用80类模型。星号*表示用于处理通用80类的模型。所有模型均在”Person”类别上进行评估,不包括_Small_人。如前所述,仅在”Person”类别上进行训练可能会导致过拟合问题。

在实验中报告了这些 Baseline 模型的最佳结果。具体而言,Faster R-CNN进行了1x的训练,Mask R-CNN进行了2x的训练。有关 Baseline 模型详细信息的更多细节请参阅”Details about Baseline Models”部分。

Effect of HumanQuery-Instance Matching

在表A4中使用ResNet-50 Backbone 网络定量分析HumanQuery-Instance(HQ-Ins)匹配对COCO-UniHuman验证集的影响。请注意,在实验中使用了标准的100-epoch训练设置。

作者报告了’Det’,’Seg’,’Kpt’,’Gener’和’Age’的AP,分别表示检测,关键点估计,实例分割,性别和年龄估计。作者展示了作者提出的HQ-Ins匹配的有效性,即在使多任务HCP学习优化更一致的同时,实现了多个人类为中心分析任务之间的更好的平衡。

Qualitative Results

在图A3和图A4中展示了使用ResNet-50 Backbone 网络的HQNet的一些定性结果。在图A3中展示了在COCO-UniHuman验证集上的一些定性结果,包括人类检测,人类姿态估计,人类实例分割和人类属性识别。该模型可以识别不同人的性别和年龄。

在图A4中,作者可视化了人类检测和跟踪(相同颜色对应相同ID),人类姿态估计,人类实例分割,性别估计和年龄估计的结果。如主论文中”Unseen-task generalization”部分所述,在PoseTrack21数据集上直接应用HQNet进行多目标跟踪(带有姿态估计和分割),其中作者的模型仅在COCO-UniHuman图像数据集上进行训练,没有针对视频数据集(如PoseTrack21)进行明确的多目标跟踪(MOT)调整。

请注意结果是通过基于图像的人类分析获得的,没有进行进一步的平滑后处理。学习得到的人类 Query ,它编码了空间和视觉线索,可以作为区分不同人类实例的良好嵌入特征。

因此,作者的人类跟踪对重叠具有鲁棒性,并且可以从重叠中恢复ID。HQNet实现了一个全面的一站式人类分析系统,可以实现多种功能:具有人类姿态估计的多目标跟踪,人类实例分割和人类属性识别。

Attention Visualization

在图A5中可视化了不同HCP模型中可变形注意力的采样位置。展示了HQNet-ResNet50中最后解码层的采样结果。每个采样点都被 Token 为红色填充的圆圈。左侧结果来自用于检测和分割的模型()。中间结果来自用于检测和关键点()的模型。右侧结果来自用于检测、分割、关键点和属性()的模型。

在分割任务中,作者注意到一些的采样点分布在人体边界附近,而另一些分布在背景中以捕获更多的上下文信息。的采样点更有可能在人体内部分布,并且其中一些点更接近定义的人体关键点,尤其是脸、手臂和腿。将和的特性结合在一起。

Appendix A4 More Implementation Details

Loss Functions

在这项工作中,作者同时训练多个人类为中心感知(HCP)任务,包括人类检测,人类实例分割,人类姿态估计和人类属性(性别和年龄)识别。

对于人类检测,作者遵循DINO的方法,应用focal loss进行分类和检测损失(L1回归损失和GIOU损失)。对于人类姿态估计,作者遵循PETR的方法,使用focal loss分类有效和无效人类实例,L1关键点回归损失,OKS损失和辅助热力图损失。

对于分割损失,作者使用二进制交叉熵损失和dice损失。对于属性识别,作者使用二进制交叉熵损失进行性别估计和均值方差损失进行年龄估计和。

正式地,整体损失函数可以表示为这些子任务损失函数的线性组合:

其中,s是相应的损失权重。损失权重的详细设置可以在表A5中找到。

Details about Training

遵循DINO的设置,通过随机裁剪、随机翻转和随机缩放来增强输入图像。具体而言,将输入图像随机缩放到较短的一侧在480和800像素之间,较长的一侧小于或等于1333像素。

这些模型使用AdamW优化器进行训练,基本学习率为,动量因子为0.9,权重衰减为。对于所有实验,模型都进行了100个周期的训练,总批量大小为16,初始学习率在第80个周期衰减为0.1。作者使用16个Tesla V100 GPU进行模型训练。

在实验中,作者报告了三种不同 Backbone 网的结果:ResNet-50 Backbone 网在ImageNet-1K数据集上进行预训练,Swin-L Backbone 网在ImageNet-22K数据集上进行预训练,ViT-L Backbone 网的预训练权重来自[74]。与DINO和Mask DINO一样,没有使用Objects365数据集预训练模型,而是仅使用COCO-UniHuman数据集进行训练。

对于所有 Backbone 网,作者都将4个 Scale 的特征图输入到编码器,并使用一个额外的超分辨率特征图进行掩码预测。与DINO和MaskDINO使用Swin-L模型的5个 Scale 不同,遵循DETR类似模型的常见做法,使用6层Transformer编码器和6层Transformer解码器,并将隐藏特征维度设置为256。使用300个 Query 和100个CDN对进行训练。遵循[106]的做法,作者在每个解码层使用独立的辅助头来细化多任务预测。

Details about Inference

在推理阶段,输入图像被重新缩放到较短的一侧为800,较长的一侧最多为1333。所有报告的数字均未经过模型集成或测试时增强(翻转测试和多 Scale 测试)。

Appendix A5 Details about Baseline Models

人类检测 Baseline 的详细信息。 对于人类检测,作者比较了两个 Baseline 方法,即Faster-RCNN和DINO。请注意,这些通用目标检测器最初是针对80个类别进行训练的(如表A3中所示)。

为了进行公平的比较,作者使用MMDetection重新训练并在”Person”类别上使用默认实验设置进行评估。请注意,MMDetection的重新实现可能比原始实现略好。

人类姿态估计 Baseline 的详细信息。 对于人类姿态估计,作者与几种代表性的人类姿态估计方法进行比较,包括自上而下方法(SBL, HRNet, Swin和PRTR),自下而上方法(HrHRNet, DEKR,和SWAHR)和单阶段方法(FCPose, InsPose, PETR和CID)。

请注意,提出的方法无法处理目标的语义分割。

Swin(Swin-L)和CID(R-50-FPN)的结果来自MMPose,其他结果来自它们的原论文。自上而下方法通常产生更好的性能,但通常依赖于单独的人体检测器,导致冗余计算成本。

具体而言,SBL,HRNet和Swin使用[87]提供的相同的人体检测器,这是一个强大的基于Faster-RCNN的检测器,在COCO’2017验证集的”Person”类别上的检测AP为56.4。PRTR应用了一个基于DETR的人体检测器进行人类检测,在COCO’2017验证集的整个”Person”类别上达到了50.2的AP。

虽然PRTR引入了一个端到端变体(E2E-PRTR)来优化检测和姿态的联合,但它仍然落后于单独训练的自上而下方法。对于姿态估计,SBL,HRNet和Swin的输入分辨率设置为256×192,而PRTR的输入分辨率设置为384×288。自下而上方法学习实例无关的关键点,然后将它们聚类到相应的个体中。HrHRNet,DEKR和SWAHR采用强大的HRNet-w32 Backbone 网络,输入分辨率设置为512×512。

单阶段方法直接在单阶段预测人类身体关键点。FCPose,InsPose和PETR采用R-50 Backbone 网络。输入图像被重新缩放到最短的一边为800,最长的一边小于或等于1333。对于CID,作者报告了R-50-FPN和HRNet-w32 Backbone 网络的结果。CID的输入分辨率设置为512×512。

对于人类实例分割,作者将HumanQuery与最先进的通用和人类特定实例分割方法进行对比。Mask R-CNN是一种端到端的下采样方法,它同时优化目标检测和实例分割。由于采用单阶段 Pipeline ,还与单阶段方法进行比较,包括PolarMask,MEInst,YOLACT和CondInst。PolarMask,MEInst,YOLACT和CondInst的结果来看,这是通过在COCO “Person”类别上重新训练和评估模型获得的。PolarMask将实例分割编码为坐标,而MEInst将分割编码为紧凑的表示向量。YOLACT和CondInst使用一系列全局原型和线性系数来表示实例分割。相比之下,作者学习具有实例意识的Human Query来解耦每个人类实例。

性别和年龄估计 Baseline 的详细信息。 多个人类性别和年龄估计在文献中仍然受到低估。使用StrongBL和Mask R-CNN建立 Baseline 。StrongBL是一种自上而下的方法,需要一个现成的检测器。对于检测部分,使用预训练的Mask RCNN来产生人类检测结果。对于属性部分,遵循官方设置,在COCO-UniHuman数据集上重新训练StrongBL。性别和年龄模型使用ResNet50作为 Backbone ,输入分辨率设置为256×192。Mask R-CNN是一种自上而下的端到端方法,通过添加性别或年龄分支并使用MMDetection进行默认训练设置的重新训练。

Appendix A6 Discussion about Unifying HCP Tasks

General network architecture design

有一些尝试设计通用网络架构来统一人类为中心感知任务。一些工作提出设计网络 Backbone 用于HCP任务。CNN基础的网络 Backbone (例如HRNet)和Transformer基础的网络 Backbone (例如TCFormer)被提出用于通用人类为中心视觉任务。其他工作则专注于设计网络 Head 以统一不同的HCP任务。例如,UniHead设计了一个新颖的感知头,其中包含了可以用于不同HCP任务的统一关键点表示。Point-Set Anchors设计了一些不同的点集 Anchor 点,为不同的HCP任务提供任务特定的初始化。与这些方法不同,作者将在单个网络中整合不同的HCP任务。

Pre-training on HCP tasks

也有一些工作在具有大规模数据的多样化人类为中心任务上进行预训练。HCMoC引入了一个通用的多模态(RGB-D)预训练框架,用于单人姿态估计和分割。SOLIDER提出了一种自监督学习框架,可以学习具有更多语义信息的通用人类表示。HumanBench构建了一个大规模的人类为中心预训练数据集,并引入了具有层次权重共享的项目辅助预训练方法。

更 recently, UniHCP提出了一种统一的视觉 Transformer 模型,用于在规模上进行多任务预训练。它使用任务特定的 Query 来关注相关的特征,但一次只解决一个任务。与作者的方法不同,作者的方法在一次正向传播中同时解决多个HCP任务。作者提出的这种方法与基于预训练的方法不同。

首先,这些方法主要关注预训练阶段,并且需要针对特定下游任务进行微调以获得最佳性能。

其次,这些方法需要在多个人类为中心感知数据集上进行大规模的联合训练。这使得直接比较与仅训练在单个特定数据集上的模型是不公平的。

此外,大规模模型训练非常昂贵。例如,UniHCP的训练需要超过10,000个GPU小时。第三,这些方法是针对单人人类分析(或自上而下的人类分析)。相比之下,作者的方法以单阶段多任务方式解决多个HCP任务。

Co-learning on HCP tasks

许多工作研究了HCP任务之间的相关性。例如,[75]探索将细粒度人物属性学习集成到行人检测 Pipeline 中。Mask-RCNN通过添加额外的关键点定位或分割分支来处理姿态估计和实例分割。Pose2Seg提出了一种基于姿态的实例分割的顶级方法。它使用先前生成的姿态作为输入,而不是区域 Proposal 来提取特征,以更好地对齐,并执行下游实例分割任务。

PersonLab采用自下而上的方案,通过应用贪心解码过程进行人类分组,解决姿态估计和实例分割。作者提出了一种单阶段模型,该模型学习一种通用统一的表示,以同时处理所有代表性的人类为中心感知任务。

Appendix A7 Discussion about Human Attribute Recognition

视觉识别人类属性是计算机视觉的一个重要研究话题。在所有人类属性中,性别和年龄无疑是最受欢迎和最具代表性的,这也是作者的主要关注点。

Dataset

人类属性识别数据集可以分为两大类,即面部属性识别数据集和行人属性识别数据集。大多数现有的属性识别数据集只提供中心裁剪的面部图像(面部属性识别)或身体(行人属性识别)图像,这使得它们不适合开发和评估多人员属性识别算法。

相比之下,作者提出的COCO-UniHuman保留了原始的高分辨率图像,并为每个人类实例密集地标注了属性。唯一的例外是WIDER-Attr,它也提供了原始图像。然而,图像数量相对较小。作者希望作者的数据集可以成为多人员人类属性识别的良好替代基准数据集。

年龄估计数据集可以分为三个组,即年龄组分类、真实年龄估计和表面年龄估计。据作者所知,公共大规模行人属性数据集(例如WIDER-Attr,PETA,Market1501-Attr,RAP-2.0和PA-100K)只有粗略的年龄组标注。面部属性数据集可能也有细粒度的表面年龄(例如APPA-REAL)或真实年龄(例如MegaAge)标注。表面年龄估计主要关注一个主体“看起来像”多少岁,而不是实际上多少岁。它被认为是视觉分析的更实际设置。

作者提出的数据集是第一个大规模野外身体表面年龄估计的数据集。身体表面年龄估计在面部图像不清晰的情况下(例如在远处拍摄)尤其有前途。然而,身体表面年龄估计在文献中受到低估,因为缺乏数据集。作者希望作者提出的COCO-UniHuman数据集可以促进相关研究。

Method

人类属性识别关注为每个人类实例分配一组语义属性(例如性别和年龄)。典型的方法包括基于全局图像的方法,基于局部部分的方法,以及基于视觉注意的方法。大多数方法都专注于单个人(或自上而下)的分析,而没有考虑不同人类实例之间的关系。相比之下,作者引入了一种单阶段多人员人类属性(例如性别和年龄)识别方法。

参考

[1].You Only Learn One Query: Learning Unified Human Query for Single-Stage Multi-Person Multi-Task Human-Centric Perception.

点击上方卡片,关注「AI视界引擎」公众号