开源大模型:从一个大模型赢者通吃,到开源模型百花齐放还有很多机会,共识的切换,只需要一个月

ChatGPT引爆「向量数据库」赛道!两家公司共获10亿元融资

文章来源:AIGC开放社区

-

向量数据库平台火爆:近期,两家初创公司Pinecone和Weaviate分别获得了B轮融资,金额分别为1亿美元和5000万美元,显示出向量数据库市场的火爆程度。

-

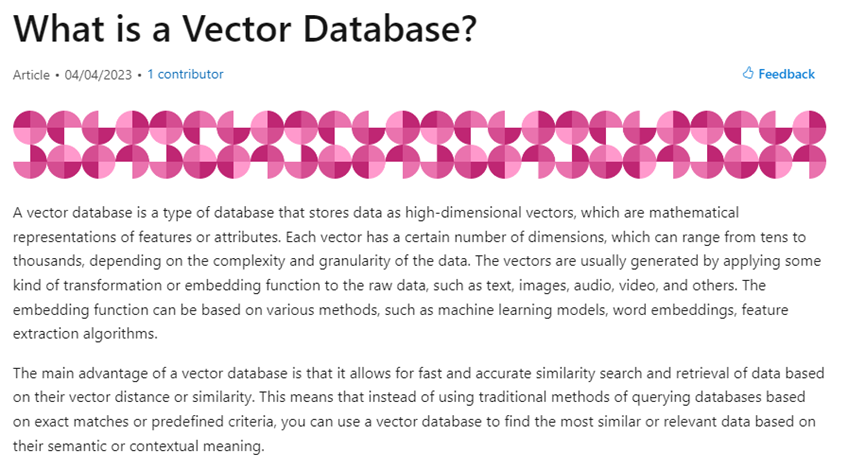

向量数据库在生成式AI应用中的作用:向量数据库为类似ChatGPT的大语言模型、应用、衍生产品提供“后勤服务”,成为下一代生成式AI应用的主要数据库存储。

-

Pinecone和Weaviate计划降低使用门槛:目前,向量数据库存储主要为大型科技巨头所使用,两家公司希望简化使用流程、降低成本,让中小型企业和个人开发者也能使用向量数据库。

-

全球AI技术和服务支出预测:据IDC调查数据,全球在AI技术和服务上的支出预计到2023年将达到1540亿美元,到2026年将超过3000亿美元,向量数据库为AI的开发和内容生成的准确性提供了重要技术支持。

几行代码,GPT-3变ChatGPT!吴恩达高徒、华人CEO震撼发布Lamini引擎

文章来源:新智元

-

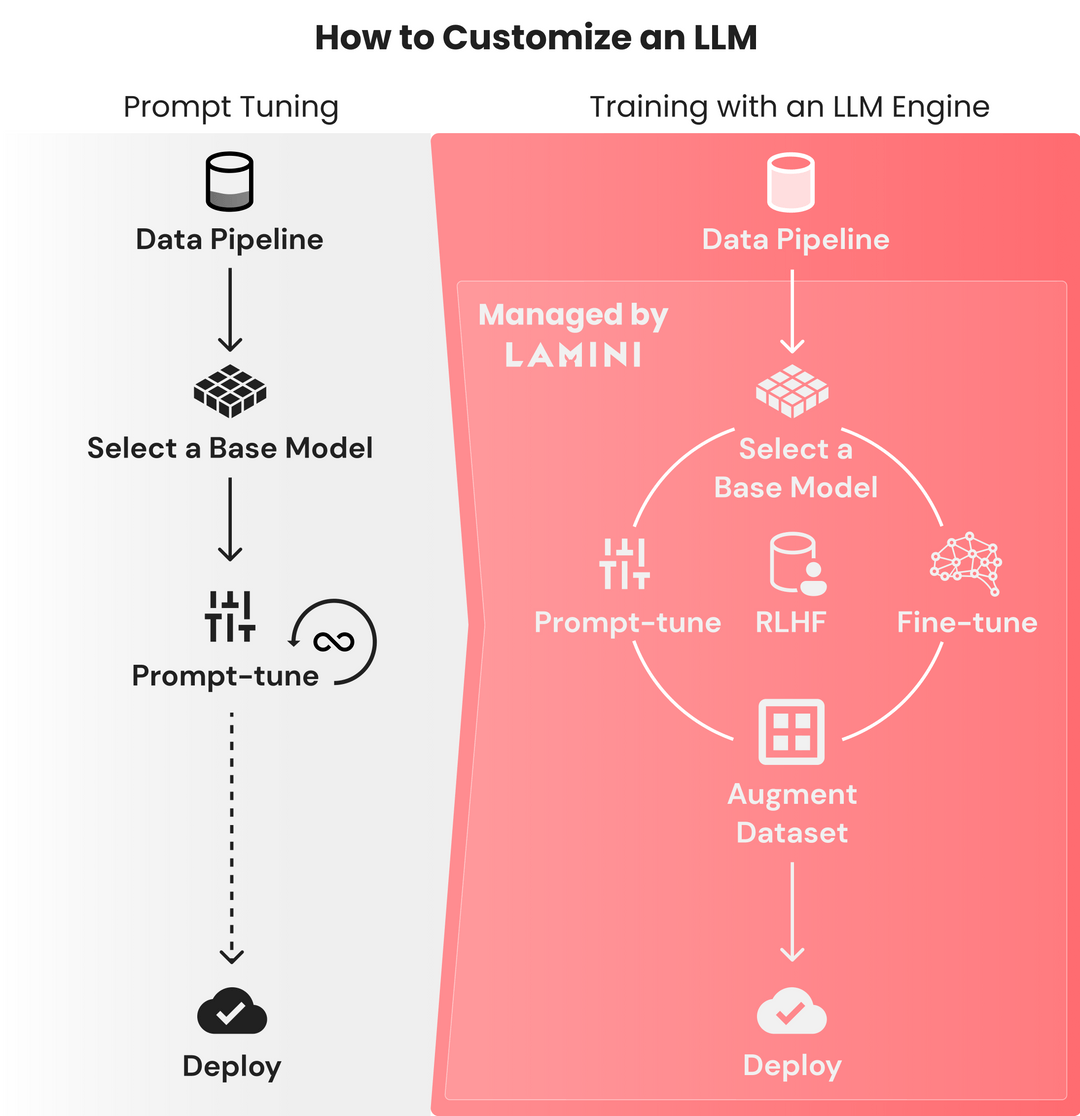

Lamini引擎推出:允许每个开发者拥有从GPT-3训练ChatGPT的能力,降低大语言模型(LLM)训练的门槛。

-

开源并可商用:Lamini提供了商业使用许可,开发者可以利用该引擎进行模型训练和微调。

-

LLaMa+自定义数据新范式:Lamini的推出引领了一种新模式——FaaS(微调即服务)。

-

用Lamini创建自己的ChatGPT:通过Lamini库的几行代码,开发者可以在大型数据集上训练高性能的LLM。

-

模型训练变得更快、更有效:Lamini库的出现提高了模型构建和迭代周期的效率,让更多人能够构建模型。

Stability AI连扔两个王炸!首个开源RLHF模型登基,DeepFloyd IF像素级出图

文章来源:新智元

-

Stability AI发布了世界首个基于RLHF的开源LLM聊天机器人——StableVicuna:StableVicuna是基于Vicuna-13B模型实现的,这是第一个使用人类反馈训练的大规模开源聊天机器人。经过实测,StableVicuna被评为当前最强大的13B LLM模型,这被认为是自ChatGPT推出以来的第二个里程碑。

-

StableVicuna的创新性训练方法:StableVicuna是以Vicuna为基础模型,通过混合三个数据集进行监督微调(SFT)得到的。在此基础上,研究者使用了trlX进行奖励模型的训练,然后通过近端策略优化(Proximal Policy Optimization, PPO)强化学习进行RLHF训练,最终实现了StableVicuna。

-

StableVicuna的未来发展:据Stability AI称,他们会进一步开发StableVicuna,并且会很快在Discord上推出。他们还计划给StableVicuna一个聊天界面,目前正在开发中。

-

StableVicuna的使用限制:开发者可以在Hugging Face上下载模型的权重,作为原始LLaMA模型的增量。但如果想使用StableVicuna,还需要获得原始LLaMA模型的访问权限。并且,StableVicuna是不允许商用的。

-

Stability AI发布了开源模型DeepFloyd IF:这是一个文本到图像的级联像素扩散模型,功能超强,可以巧妙地把文本集成到图像中。DeepFloyd IF的革命性意义在于,它一连解决了文生图领域的两大难题:正确生成文字,正确理解空间关系。

熔岩羊驼LLaVA来了:像GPT-4一样可以看图聊天,无需邀请码,在线可玩

文章来源:机器之心

-

LLaVA多模态大模型:由威斯康星大学麦迪逊分校、微软研究院和哥伦比亚大学研究者共同发布。

-

图文理解能力:LLaVA展示了与多模态模型GPT-4相似的图文理解能力,相对于GPT-4获得了85.1%的相对得分。

-

最先进的科学问答水平:LLaVA在科学问答(Science QA)任务上与GPT-4协同作用,实现了92.53%的准确率,达到了新的最先进水平。

-

多模态指令数据的重组方式:使用ChatGPT/GPT-4将图像-文本对转换为适当的指令格式。

-

端到端微调:研究者通过连接开源视觉编码器CLIP和语言解码器LLaMA,开发了大型多模态模型LLaVA,并在生成的视觉-语言指令数据上进行了端到端微调。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...