Enhancing ChAIn-of-Thoughts Prompting with Iterative Bootstrapping in Large Language Models

提出Iter-CoT,一种迭代bootstrapping的CoT提示方法,可以使大型语言模型更准确地生成推理链,提高推理性能和泛化能力。

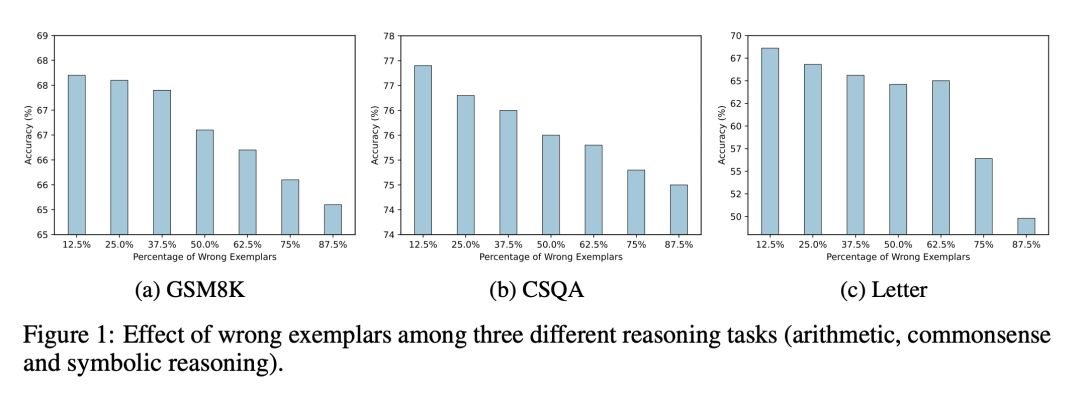

解决问题:本篇论文旨在解决大型语言模型在推理任务中可能出现的错误推理问题,提出了一种迭代自我纠正的方法,以选择合适的示例和生成推理链,从而提高模型的推理精度和综合性能。

关键思路:论文提出的关键思路是Iter-CoT(迭代自举链式思考提示),通过迭代自我纠正来选择合适的示例和生成推理链,从而提高模型的推理精度和综合性能。相比于当前领域的研究,该方法的新意在于迭代自我纠正的思想,能够使模型更加准确地推理。

其他亮点:论文的实验结果表明,Iter-CoT在11个数据集上的三个不同推理任务中表现出了优异的性能,具有很高的竞争力。值得关注的是,该方法选择了具有一定难度但可回答的问题作为示例,从而增强了模型在不同难度级别上的泛化能力。此外,论文还提供了数据集和代码。

关于作者:

孙家硕、罗毅、龚业云、林晨、沈业龙、郭健和段楠,他们来自微软亚洲研究院和清华大学。

[Xiamen University & Microsoft Research Asia]

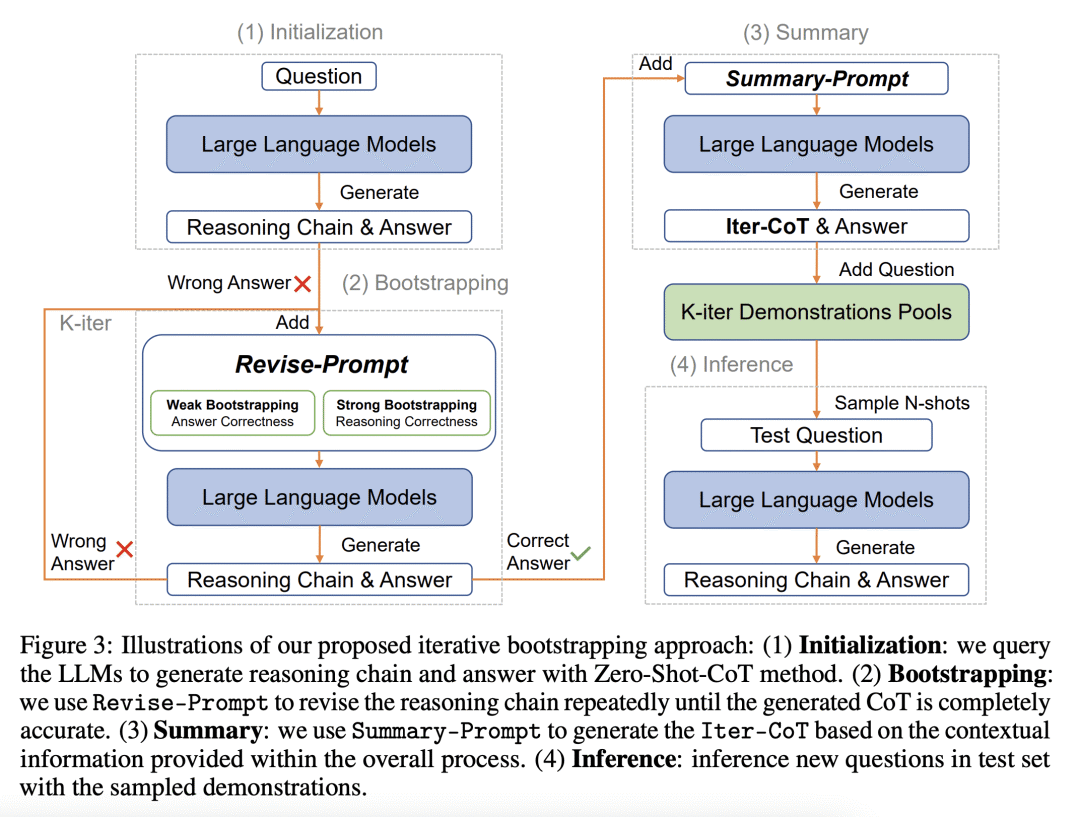

论文摘要:本文介绍了一种迭代自举方法,名为Iter-CoT(Iterative bootstrapping in Chain-of-Thoughts Prompting),用于选择示例和生成推理链以增强大型语言模型(LLMs)中的思维链提示。通过利用迭代自举,该方法使LLMs能够自主纠正错误,从而产生更精确和全面的推理链。同时,该方法选择具有适度难度水平的具有挑战性但可回答的问题和推理链作为示例,从而增强LLMs在各种难度水平上的泛化能力。实验结果表明,Iter-CoT表现出卓越的优势,在11个数据集上的三个不同推理任务中取得了竞争性的性能。

-

动机:解决大型语言模型在推理链生成过程中存在的错误和难度过大的问题,提高推理性能和泛化能力。 -

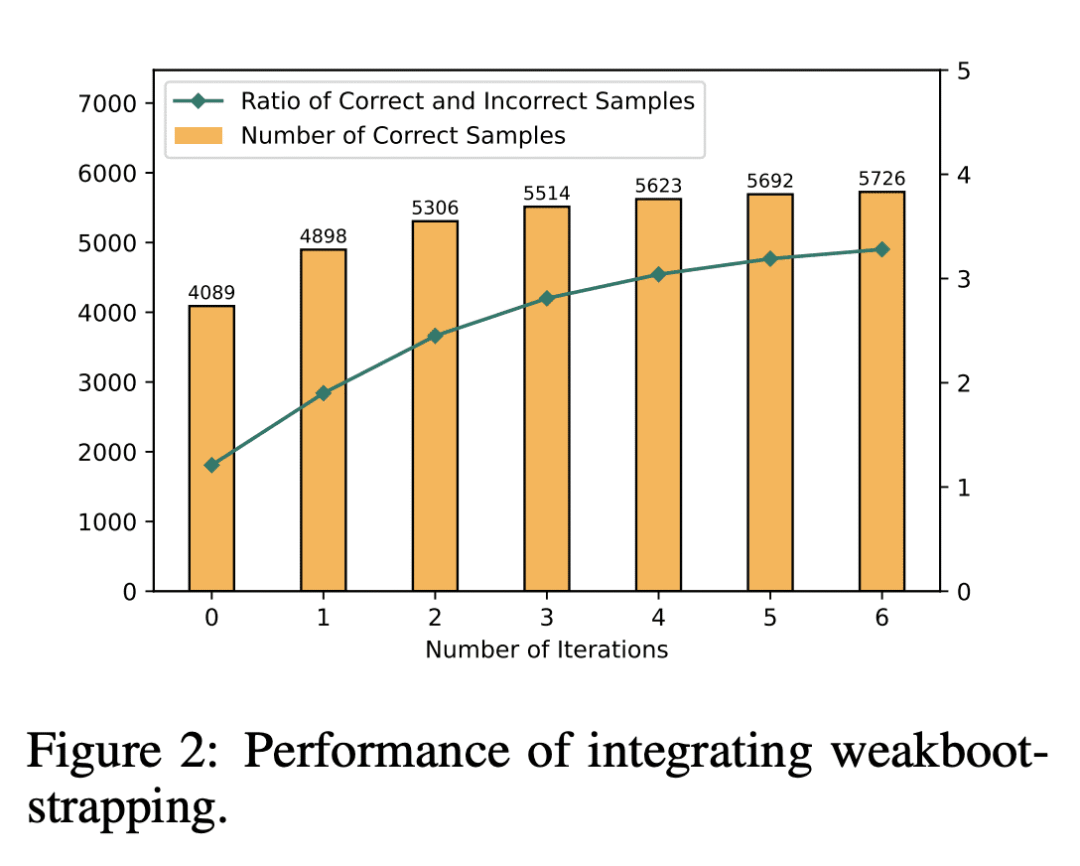

方法:使用Iter-CoT方法,通过迭代bootstrapping的方式选择样本并生成推理链,使大型语言模型自我纠正,并选择适当难度的问题作为典型样本,提高泛化能力。其中,weak bootstrapping和strong bootstrapping是两种方法,分别提供不同的监督信息。 -

优势:Iter-CoT方法在三种不同的推理任务上展示出竞争性的表现,通过选择适当难度的问题作为样本和迭代bootstrapping的方式,提高了推理性能和泛化能力。

https://arxiv.org/abs/2304.11657