PMC-LLaMA: Further Finetuning LLaMA on Medical Papers

本文提出一种基于生物医学文献的预训练语言模型PMC-LLaMA,通过对LLaMA模型进行微调,注入医疗知识以增强其在医疗领域的能力,从而提高其在医疗问答基准测试中的表现。

解决问题:

该论文旨在解决在医学领域中,大型语言模型(LLMs)由于缺乏领域特定知识而表现不佳的问题。作者通过在4.8百万篇生物医学论文上进行微调,提出了一个新的开源语言模型PMC-LLaMA,以进一步注入医学知识,增强其在医学领域的能力。

-

动机:大型语言模型在多个领域表现出了卓越的自然语言理解能力,但在医疗领域的精度要求较高的任务中表现不佳,原因是缺乏领域特定的知识。 -

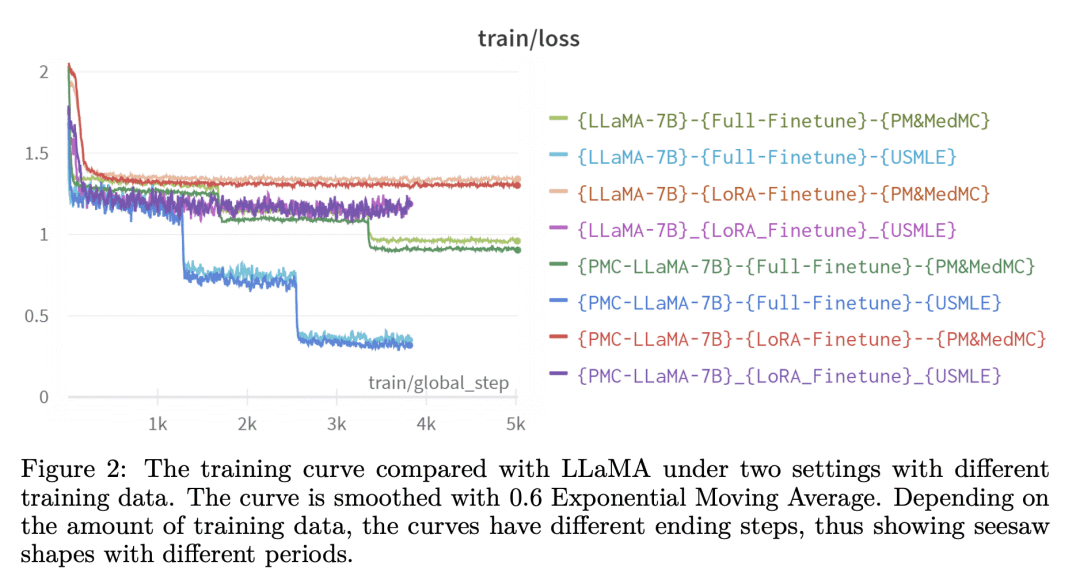

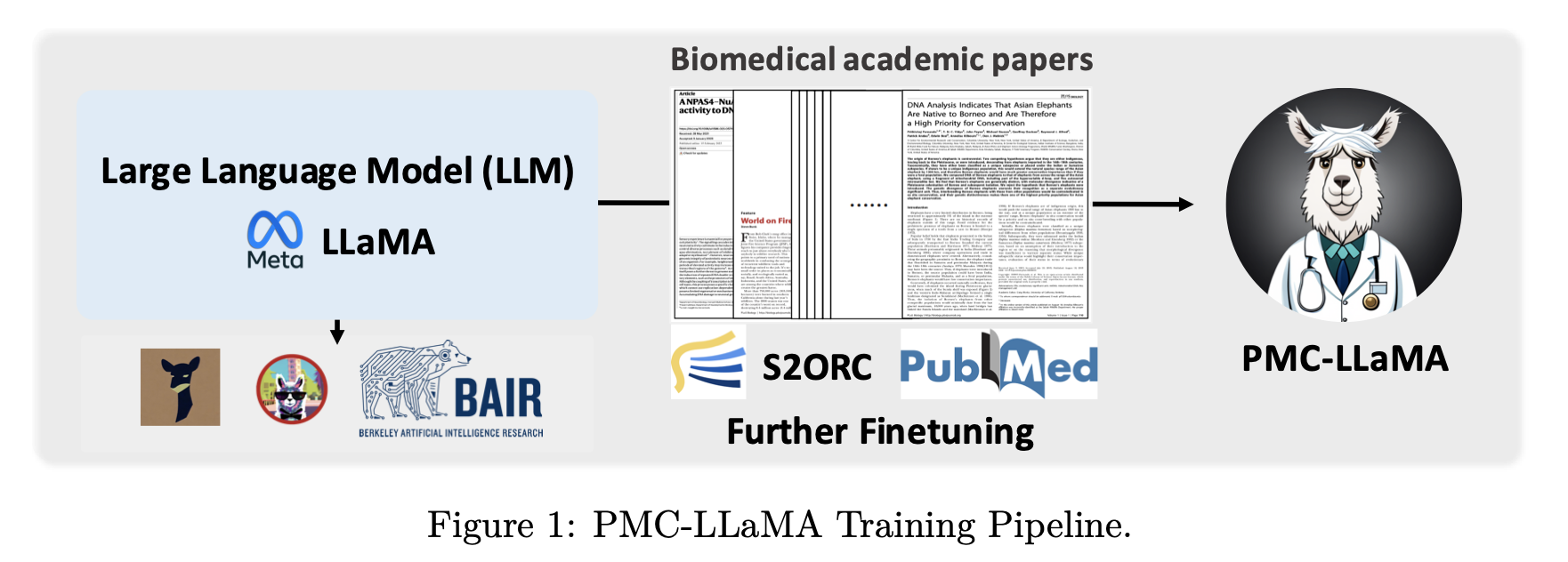

方法:通过对LLaMA模型进行微调,注入医疗知识以增强其在医疗领域的能力,从而提高其在医疗问答基准测试中的表现。使用4.8百万篇医学学术论文进行微调,得到了一个新的基于医疗领域的模型PMC-LLaMA。 -

优势:PMC-LLaMA模型表现出更好的医疗领域特定概念的理解能力,其在医疗问答基准测试中的表现也更好。

关键思路:

文章的关键思路是通过在大量医学论文上进行微调,将LLMs注入医学知识,以提高其在医学领域中的表现。相比当前的研究状态,该论文的新意在于提出了一种新的解决方案,以提高LLMs在医学领域中的性能。

其他亮点:

该论文的亮点在于作者提出了一个新的开源语言模型PMC-LLaMA,并在三个生物医学问答数据集上进行了初步评估,表现出更好的医学领域特定概念理解能力,从而在QA基准测试中取得了高性能。该模型和代码以及在线演示均已公开发布。该论文的工作值得进一步深入研究。

关于作者:该论文的主要作者是Chaoyi Wu、Xiaoman Zhang、Ya Zhang、Yanfeng Wang和Weidi Xie。

Cooperative Medianet Innovation Center, Shanghai Jiao Tong University、Shanghai AI Laboratory

项目地址:

https://github.com/chaoyi-wu/PMC-LLaMA

https://arxiv.org/pdf/2304.14454.pdf

相关研究:

近期其他相关的研究包括“BERT for Clinical Text Classification: Is Finetuning Really Necessary”(作者:Yanshan Wang、Shuangyin Wang、Xiaolong Wang、Jingyu Liu、Tianxing Wu,机构:香港中文大学)、“ClinicalBERT: Modeling Clinical Notes and Predicting Hospital Mortality”(作者:Zhiqing Sun、Yue Wang、Xiaolong Wang、Tianxing Wu,机构:香港中文大学)等。

论文摘要:

在医学领域,精度至关重要。然而,大型语言模型(LLMs)由于缺乏领域特定的知识,通常在日常对话或问答场景中表现良好,但在医学应用中表现不佳。本文介绍了PMC-LLaMA,这是一个开源的语言模型,通过在480万篇生物医学学术论文上微调开源语言模型来注入医学知识,增强其在医学领域的能力。我们在三个生物医学问答数据集上进行了初步评估,包括PubMedQA、MedMCQA和USMLE,结果显示我们的模型经过微调后,即PMC-LLaMA,对生物医学领域特定概念有更好的理解,从而在问答基准测试中表现出高水平的性能。该模型和代码以及在线演示均可公开获取。