思维链提示(CoT)是大模型涌现中最神秘的现象之一,尤其在解决数学推理和决策问题中取得了惊艳效果。CoT到底有多重要呢?它背后成功的机制是什么?本文中,北大的几位研究者证明了CoT在实现大语言模型(LLM)推理中是不可或缺的,并从理论和实验角度揭示了CoT如何释放LLM的巨大潜力。

思维链提示(Chain of Thought prompting,简称为 CoT)可以显著提升大语言模型(LLM)的性能,尤其适用于处理涉及数学或推理的复杂任务。不过尽管取得了很大成功,但 CoT 背后的机制以及如何释放 LLM 的潜力仍然难以捉摸。

论文链接:https://arxiv.org/abs/2305.15408

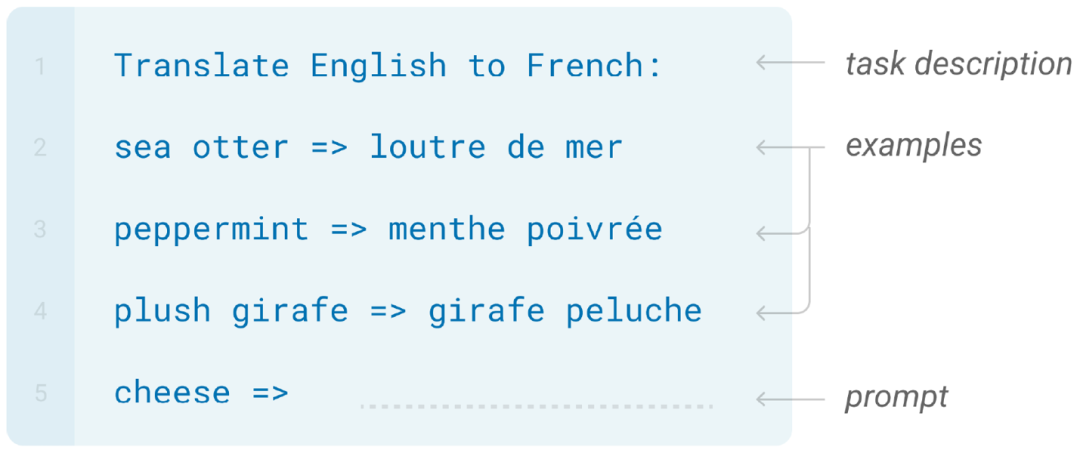

基于 Transformer 的大语言模型已经成为自然语言处理中的通用模型,在各种任务上都获得了广泛的应用。主流的大模型通常基于自回归范式来实现,具体而言,各种不同的任务(如文本翻译、文本生成、问题回答等)都可以统一地视为序列生成问题,其中问题的输入和问题描述被一起被编码为一个单词(token)序列,称为提示(prompt);问题的答案便可以转化为基于提示来条件生成后续单词的任务。

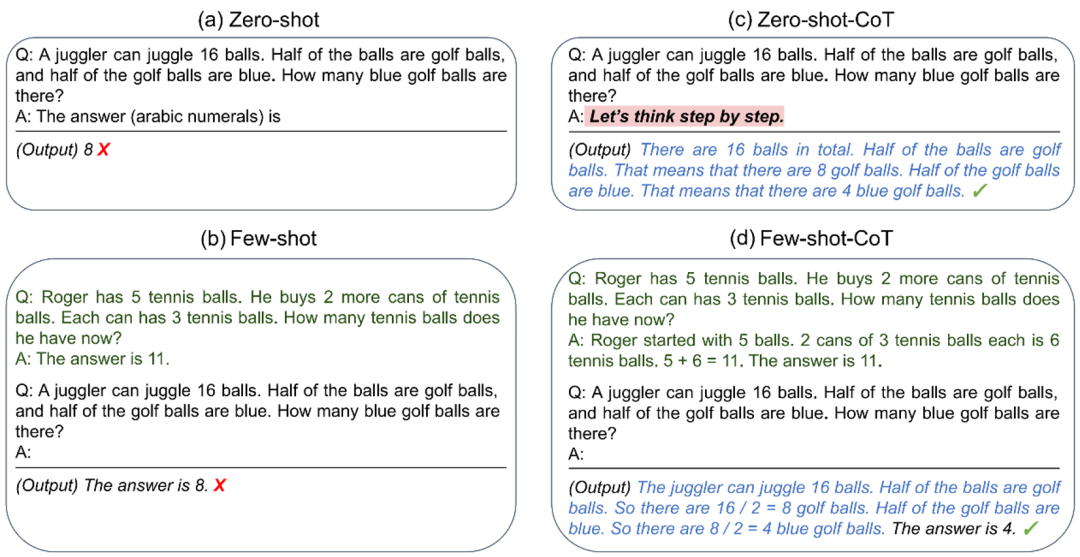

在大模型领域中有大量的研究已经表明,精心设计的提示词对模型的表现起着至关重要的作用。特别是在涉及算术或推理相关的任务时, CoT 已被表明能够大大提高所生成答案的正确性。如下图所示,对于一个需要数学推理的任务,大模型直接生成的答案往往是错误的(下图 a,b)。但是如果通过修改提示使得大模型输出整个思维链(中间推导步骤),最终便能够得到正确答案(下图 c,d)。

在实践中,思维链提示有两种主流的实现方式:一种是在提示中添加特定短语,如 “Let’s think step by step” 来触发(如上图 c);另一种是通过提供少量的思维链演示的例子来让大模型模拟相应的推导过程(如上图 d)。

尽管 CoT 在大量实验上都取得了显著的表现,但背后的理论机制却仍然是个谜。研究者从模型表达能力的角度来研究 CoT:对于数学任务和一般的决策任务,本文研究了基于自回归的 Transformer 模型在以下两个方面的表达能力:(1)直接生成答案,以及(2)采用 CoT 的方式生成完整的解决步骤。

更多内容请参考:

https://mp.weixin.qq.com/s/CoLFFQTF9QqL8lSbtaY-_Q